Heute nutzen über 5.19 Milliarden Menschen das Internet. Das ist doch ein riesiges Publikum, nicht wahr?

Die schiere Menge an Inhalten, die im Internet generiert werden, ist geradezu atemberaubend. Von Social-Media-Updates und Blogbeiträgen bis hin zu benutzergenerierten Kommentaren und Multimedia-Uploads ist die Online-Welt ein riesiger und dynamischer Informationsspeicher.

Dennoch sind nicht alle Inhalte gut. Einige könnten verschiedene Gruppen aufgrund von Alter, Rasse, Geschlecht, Nationalität oder ethnischer Zugehörigkeit beleidigen. Solche Inhalte erfordern eine sorgfältige Beobachtung. Dies sorgt für Frieden und Harmonie für alle.

Daher besteht ein dringender Bedarf an der Moderation von Inhalten. Auch wenn die manuelle Überprüfung effektiv ist, gibt es bestimmte Einschränkungen, die wir nicht ignorieren können. Und hier kommt die automatisierte Content-Moderation als effektive Lösung ins Spiel. Diese effiziente Methode sorgt für sichere Online-Erlebnisse und schützt Benutzer vor potenziellem Schaden.

In diesem Artikel werden wir über die unschätzbaren Vorteile und die verschiedenen Arten sprechen, die in automatisierten Moderationstools (vorab trainiert mit robusten Datensätzen) verfügbar sind.

Grundlegendes zur automatisierten Inhaltsmoderation

Die automatisierte Inhaltsmoderation nutzt Technologie, um benutzergenerierte Inhalte zu überwachen und zu verwalten. Anstatt dass Menschen jeden Beitrag scannen, erledigen Algorithmen und maschinelles Lernen die schwere Arbeit. Sie erkennen schnell schädliche oder unangemessene Inhalte. Diese Systeme lernen aus riesigen Datensätzen und treffen Entscheidungen auf der Grundlage festgelegter Kriterien, die zuvor mit Human-in-the-Loop trainiert wurden.

Automatisierte Methoden zur Inhaltsmoderation können sehr effizient sein. Sie arbeiten rund um die Uhr und überprüfen sofort große Inhaltsmengen. Sie ergänzen jedoch auch menschliche Gutachter. Manchmal ist eine menschliche Note für den Kontext unerlässlich. Diese Mischung sorgt für sicherere Online-Räume, da Benutzer das Beste aus beiden Welten erhalten.

Möchten Sie eine Plattform ohne schädliche Inhalte? Die automatisierte Moderation von Inhalten ist der Weg in die Zukunft. Wir werden es klarer machen, wenn Sie die Arten und Vorteile unten lesen.

[Lesen Sie auch: Der notwendige Leitfaden zur Inhaltsmoderation]

Arten der automatisierten Moderation

Die automatisierte Inhaltsmoderation hat sich im Laufe der Jahre erheblich weiterentwickelt. Es umfasst mittlerweile ein Spektrum an Technologien und Ansätzen, die jeweils auf spezifische Bedürfnisse zugeschnitten sind. Hier ist ein genauerer Blick auf die verschiedenen Typen:

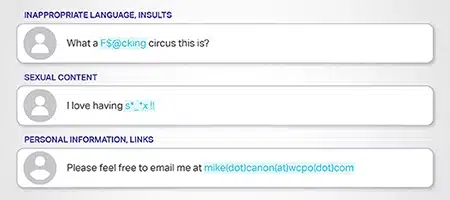

Keyword-basierte Moderation

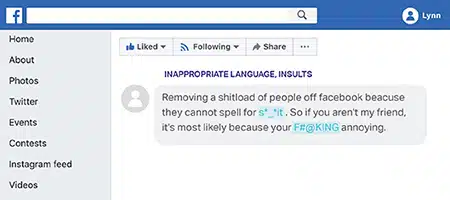

Diese Methode funktioniert mit vordefinierten Listen verbotener oder markierter Wörter. Wenn Inhalte diese Wörter enthalten, verweigert das System entweder die Veröffentlichung oder sendet sie zur Überprüfung. Beispielsweise könnten Plattformen explizite Sprache oder Begriffe im Zusammenhang mit Hassreden blockieren.

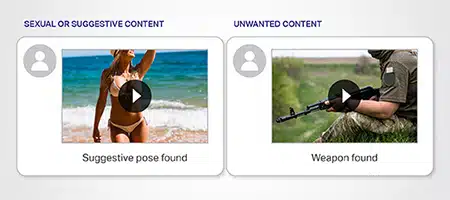

Moderation der Bilderkennung

Diese Methode nutzt die Leistungsfähigkeit des maschinellen Lernens und identifiziert unangemessene oder markierte Bilder. Es kann Bilder erkennen, die Gewalt, explizite Inhalte oder urheberrechtlich geschütztes Material fördern. Fortschrittliche Algorithmen analysieren visuelle Muster, um sicherzustellen, dass kein schädliches Bild unbemerkt bleibt.

Moderation von Videoanalysen

Ähnlich wie bei der Bilderkennung werden bei der Videoanalyse Videokomponenten Bild für Bild zerlegt. Es sucht nach unangemessenen Bildern, Audiohinweisen oder gekennzeichneten Inhalten. Es ist von unschätzbarem Wert auf Plattformen wie YouTube, wo Videoinhalte dominieren.Moderation der Stimmungsanalyse

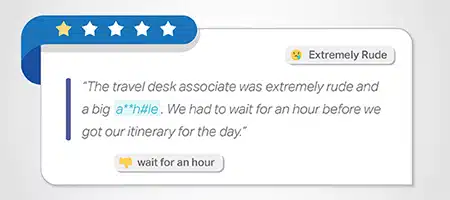

Es ist von entscheidender Bedeutung, die Stimmung oder Emotion hinter dem Inhalt zu verstehen. Diese Methode bewertet den Inhaltston und markiert Inhalte, die übermäßig negativ sind, Hass fördern oder schädliche Gefühle fördern. Es ist besonders nützlich in Foren oder Plattformen, die positive Community-Interaktionen fördern.

Kontextuelle Moderation

Inhalte erfordern oft Kontext für eine genaue Moderation. Diese Methode bewertet Inhalte in ihrem umgebenden Kontext. Es stellt sicher, dass echte Inhalte, auch mit markierten Wörtern, nicht fälschlicherweise blockiert werden, wenn der Gesamtkontext harmlos ist. Im Beispiel enthält es das Wort „töten“, im Kontext ist es harmlos und bezieht sich auf die harmlose Aktivität des Spielens

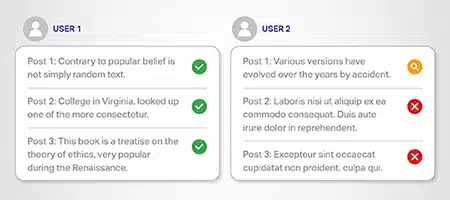

Auf der Benutzerreputation basierende Moderation

Benutzer, die in der Vergangenheit gegen Richtlinien verstoßen haben, sollten möglicherweise genauer unter die Lupe genommen werden. Dieses System moderiert basierend auf der Benutzerreputation. Bei Personen mit früheren Verstößen kann es sein, dass ihre Inhalte strenger überprüft werden als bei Personen, bei denen keine Fehler vorliegen.

Moderation der Überwachung sozialer Medien

Angesichts der riesigen Menge an Inhalten, die in sozialen Medien generiert werden, überwachen spezielle Tools diese Plattformen. Sie erkennen potenzielle Probleme wie Desinformation, Fake News oder Trolling in Echtzeit. Es trägt dazu bei, eine sauberere und sicherere Social-Media-Umgebung zu schaffen.

Vorteile der automatisierten Moderation

Automatisierung bringt verschiedene Vorteile mit sich. Schauen wir uns die Vorteile der automatisierten Content-Moderation genauer an:

Effiziente Inhaltsfilterung

Angesichts der Zunahme benutzergenerierter Inhalte (User Generated Content, UGC) benötigen Plattformen Systeme, um große Mengen zu durchsuchen. Angebote zur automatisierten Inhaltsmoderation effiziente Inhaltsfilterung. Es stellt sicher, dass nur geeignete Materialien das Licht der Welt erblicken.

Verbesserte digitale Sicherheit

Online-Sicherheit ist wichtig, um das Vertrauen der Benutzer in die Nutzung des Internets zu stärken. Automatisierung trägt zur Wahrung der digitalen Sicherheit bei, indem sie schädliche Inhalte erkennt. Von Hassreden bis hin zu Online-Belästigung – es hält solche Bedrohungen in Schach.

Einhaltung der Community-Richtlinien

Community-Richtlinien wahren die Plattformintegrität. Die Automatisierung stellt sicher, dass diese Regeln nicht verletzt werden, und trägt dazu bei, harmonische Online-Räume zu schaffen.

Bekämpfung von Online-Belästigung und Hassrede

Automatisierte Systeme können Online-Belästigung und Hassreden schnell erkennen und beseitigen. Sie stellen sicher, dass Plattformen einladend und sicher bleiben, indem sie schädliche Inhalte kennzeichnen.

Bekämpfung von Desinformation und Fake News

Im Alter von grassierende DesinformationDabei spielt die Automatisierung eine zentrale Rolle. Es erkennt und unterdrückt Desinformation/Fake News, um Wahrheit und Genauigkeit zu wahren.

Trolling bekämpfen

Trolling kann Online-Dialoge ruinieren und sinnvolle Gespräche zum Scheitern bringen. Die automatisierte Inhaltsmoderation erkennt diese Trolle und trägt dazu bei, ein positives Umfeld aufrechtzuerhalten. Stellen Sie sich ein Klassenzimmer vor. Die IT fungiert als vorsichtige Kraft, die konstruktive Interaktionen fördert und Benutzern ein besseres Erlebnis bietet.

Tiefenanalyse

Die Textanalyse geht über die reine Schlüsselworterkennung hinaus. Es versteht den Kontext und fördert echte Inhalte, während schädliche Narrative entfernt werden. Über Texte hinaus erkennen Bilderkennungstools unangemessene Bilder. Sie stellen sicher, dass die Bilder den Plattformstandards entsprechen.

Umfassende Videomoderation

Videoinhalte dominieren den digitalen Raum, da die Menschen ansprechende Bilder lieben. Die Automatisierung greift ein, um sicherzustellen, dass diese Videos bestimmte Standards einhalten. Es durchsucht riesige Inhaltsmengen, erkennt schädliche Elemente und entfernt sie umgehend.

Zusammenfassung

Die automatisierte Inhaltsmoderation bringt sowohl Vorteile als auch Herausforderungen mit sich. Es zeichnet sich dadurch aus, dass es ungeeignete Inhalte von digitalen Plattformen entfernt. Es stößt jedoch auch auf Einschränkungen und löst Debatten über Zensur und die Rolle der Technologie aus. In vielen Fällen ist bei Unklarheiten auch eine fachkundige Moderation durch Menschen erforderlich.

Plattformen sollten sich über Moderationsregeln im Klaren sein. Sie benötigen außerdem Systeme, mit denen Benutzer Entscheidungen zur Entfernung von Inhalten im Hinblick auf Fairness und Genauigkeit anfechten können. Mit der richtigen Balance können wir Fairness für Online-Nutzer erreichen und gleichzeitig ihre Sicherheit und Rechte wahren.

Diese Methode funktioniert mit vordefinierten Listen verbotener oder markierter Wörter. Wenn Inhalte diese Wörter enthalten, verweigert das System entweder die Veröffentlichung oder sendet sie zur Überprüfung. Beispielsweise könnten Plattformen explizite Sprache oder Begriffe im Zusammenhang mit Hassreden blockieren.

Diese Methode funktioniert mit vordefinierten Listen verbotener oder markierter Wörter. Wenn Inhalte diese Wörter enthalten, verweigert das System entweder die Veröffentlichung oder sendet sie zur Überprüfung. Beispielsweise könnten Plattformen explizite Sprache oder Begriffe im Zusammenhang mit Hassreden blockieren. Diese Methode nutzt die Leistungsfähigkeit des maschinellen Lernens und identifiziert unangemessene oder markierte Bilder. Es kann Bilder erkennen, die Gewalt, explizite Inhalte oder urheberrechtlich geschütztes Material fördern. Fortschrittliche Algorithmen analysieren visuelle Muster, um sicherzustellen, dass kein schädliches Bild unbemerkt bleibt.

Diese Methode nutzt die Leistungsfähigkeit des maschinellen Lernens und identifiziert unangemessene oder markierte Bilder. Es kann Bilder erkennen, die Gewalt, explizite Inhalte oder urheberrechtlich geschütztes Material fördern. Fortschrittliche Algorithmen analysieren visuelle Muster, um sicherzustellen, dass kein schädliches Bild unbemerkt bleibt.

Es ist von entscheidender Bedeutung, die Stimmung oder Emotion hinter dem Inhalt zu verstehen. Diese Methode bewertet den Inhaltston und markiert Inhalte, die übermäßig negativ sind, Hass fördern oder schädliche Gefühle fördern. Es ist besonders nützlich in Foren oder Plattformen, die positive Community-Interaktionen fördern.

Es ist von entscheidender Bedeutung, die Stimmung oder Emotion hinter dem Inhalt zu verstehen. Diese Methode bewertet den Inhaltston und markiert Inhalte, die übermäßig negativ sind, Hass fördern oder schädliche Gefühle fördern. Es ist besonders nützlich in Foren oder Plattformen, die positive Community-Interaktionen fördern. Inhalte erfordern oft Kontext für eine genaue Moderation. Diese Methode bewertet Inhalte in ihrem umgebenden Kontext. Es stellt sicher, dass echte Inhalte, auch mit markierten Wörtern, nicht fälschlicherweise blockiert werden, wenn der Gesamtkontext harmlos ist. Im Beispiel enthält es das Wort „töten“, im Kontext ist es harmlos und bezieht sich auf die harmlose Aktivität des Spielens

Inhalte erfordern oft Kontext für eine genaue Moderation. Diese Methode bewertet Inhalte in ihrem umgebenden Kontext. Es stellt sicher, dass echte Inhalte, auch mit markierten Wörtern, nicht fälschlicherweise blockiert werden, wenn der Gesamtkontext harmlos ist. Im Beispiel enthält es das Wort „töten“, im Kontext ist es harmlos und bezieht sich auf die harmlose Aktivität des Spielens Benutzer, die in der Vergangenheit gegen Richtlinien verstoßen haben, sollten möglicherweise genauer unter die Lupe genommen werden. Dieses System moderiert basierend auf der Benutzerreputation. Bei Personen mit früheren Verstößen kann es sein, dass ihre Inhalte strenger überprüft werden als bei Personen, bei denen keine Fehler vorliegen.

Benutzer, die in der Vergangenheit gegen Richtlinien verstoßen haben, sollten möglicherweise genauer unter die Lupe genommen werden. Dieses System moderiert basierend auf der Benutzerreputation. Bei Personen mit früheren Verstößen kann es sein, dass ihre Inhalte strenger überprüft werden als bei Personen, bei denen keine Fehler vorliegen. Angesichts der riesigen Menge an Inhalten, die in sozialen Medien generiert werden, überwachen spezielle Tools diese Plattformen. Sie erkennen potenzielle Probleme wie Desinformation, Fake News oder Trolling in Echtzeit. Es trägt dazu bei, eine sauberere und sicherere Social-Media-Umgebung zu schaffen.

Angesichts der riesigen Menge an Inhalten, die in sozialen Medien generiert werden, überwachen spezielle Tools diese Plattformen. Sie erkennen potenzielle Probleme wie Desinformation, Fake News oder Trolling in Echtzeit. Es trägt dazu bei, eine sauberere und sicherere Social-Media-Umgebung zu schaffen.