Die digitale Welt entwickelt sich ständig weiter, und ein Katalysator, der diese Plattform von den anderen unterscheidet, ist User Generated Content. Obwohl Unternehmen weltweit ihre Websites und dedizierte Social-Media-Präsenzen haben, vertrauen die Benutzer eher den Meinungen ihrer Mitkunden, als sich an die Worte des Unternehmens zu halten.

Mehr als 4.26 Milliarden Menschen waren aktive Social-Media-Nutzer im Jahr 2021. Eine Zahl, die bis 6 voraussichtlich die 2027-Milliarden-Marke erreichen wird. Die Menge der weltweit generierten, erfassten, geteilten und konsumierten Inhalte erreichte 64.2 2020 Zettabyte.

Da neue Inhalte in einem atemberaubenden Tempo generiert und konsumiert werden, ist es für Marken unerlässlich geworden, die auf ihren Plattformen gehosteten Inhalte im Auge zu behalten. Online-Plattformen sollen eine sichere Umgebung für ihre Nutzer sein und bleiben.

[Lesen Sie auch: Grundlegendes zur automatisierten Inhaltsmoderation]

Was ist Inhaltsmoderation und warum?

Benutzergenerierte Inhalte treiben Social-Media-Plattformen voran, und inhaltliche Moderation bezieht sich auf die Überprüfung dieser Inhalte auf unangemessene oder anstößige Beiträge. Business- und Social-Media-Plattformen haben einen spezifischen Standard für die Überwachung ihrer Hosting-Inhalte.

Die Richtlinien könnten alles beinhalten von Gewalt, Extremismus, Hassreden, Nacktheit, Urheberrechtsverletzung oder etwas Anstößiges. Der gepostete Inhalt wird markiert und entfernt, wenn er nicht dem Standard entspricht.

Die Idee hinter der Inhaltsmoderation ist es, sicherzustellen, dass der Inhalt mit den Idealen der Marke übereinstimmt und die Werte Anstand, Vertrauen und Sicherheit hochhält.

Die Moderation von Inhalten ist für Unternehmen von entscheidender Bedeutung, um Geschäftsstandards, Markenimage, Ruf und Glaubwürdigkeit aufrechtzuerhalten. Jede Sekunde macht es die erstaunliche Menge an nutzergenerierten Inhalten, die auf Plattformen gepostet werden, für Marken schwierig, sich offensiv und offensiv zu halten unpassender Inhalt, Texte, Videos und Bilder. Die Strategie zur Moderation von Inhalten hilft Marken dabei, ihr Image zu wahren, während sie es den Benutzern ermöglicht, sich auszudrücken, und anstößige, explizite und gewalttätige Inhalte abschaltet.

Welche Inhaltstypen können Sie moderieren?

Inhaltsmoderationsalgorithmen behandeln im Allgemeinen drei oder eine Kombination dieser Inhaltstypen.

Text

Die schiere Menge an Text – von Kommentaren bis hin zu Artikeln in voller Länge – die moderiert werden muss, ist ziemlich umwerfend. Textbeiträge sind fast überall in Form von Kommentaren, Artikeln, Forenbeiträgen, Diskussionen in sozialen Medien und anderen Beiträgen verfügbar.

Moderationsalgorithmen für Textinhalte sollten in der Lage sein, Text unterschiedlicher Länge und Stile nach unerwünschten Inhalten zu durchsuchen. Darüber hinaus kann die Textmoderation aufgrund der Komplexität sprachlicher und kultureller Nuancen eine schwierige Aufgabe sein.

Bilder

Die Bildmoderation ist viel einfacher als die Textmoderation, aber es ist wichtig, dass geeignete Richtlinien oder Standards vorhanden sind.

Da bei der Moderation von Bildern kulturelle Unterschiede ins Spiel kommen können, ist es außerdem wichtig, die Benutzergemeinschaft an mehreren geografischen Standorten gründlich zu verstehen und mit ihr in Kontakt zu treten.

Videos

Das Moderieren von Videoinhalten ist sehr schwierig, da das Moderieren von Videos im Gegensatz zu Text oder Bildern zeitaufwändig sein kann. Der Moderator muss sich das gesamte Video ansehen, bevor er es für geeignet oder ungeeignet für den Konsum hält. Selbst wenn nur wenige Frames im Video explizit oder störend sind, zwingt es den Moderator dazu, den gesamten Inhalt zu entfernen.

Live-Streaming

Live-Streaming ist vielleicht der schwierigste Inhalt, den es zu moderieren gilt. Dies liegt daran, dass die Video- und begleitende Textmoderation gleichzeitig mit dem Streaming erfolgen muss.

Wie funktioniert die Inhaltsmoderation?

Um mit der Moderation der Inhalte auf Ihrer Plattform zu beginnen, sollten Sie zunächst Standards oder Richtlinien einführen, die unangemessene Inhalte bestimmen. Diese Richtlinien helfen Moderatoren dabei, Inhalte zum Entfernen zu kennzeichnen.

Definieren Sie die Sensibilitätsstufe oder den Schwellenwert, den Inhaltsmoderatoren bei der Überprüfung von Inhalten berücksichtigen sollten. Der Schwellenwert sollte basierend auf Ihrer Marke, der Art des Unternehmens, den Benutzererwartungen und dem Standort definiert werden.

Arten der Inhaltsmoderation

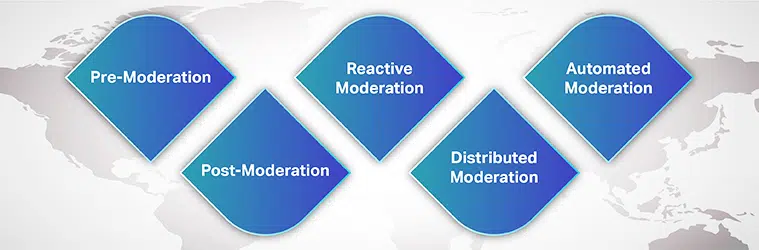

Sie können aus vielen wählen Moderationsprozesse für Ihre Markenbedürfnisse und Zustimmung des Benutzers. Einige von ihnen sind:

Vormoderation

Bevor der Inhalt auf Ihrer Website angezeigt wird, befindet er sich in der Warteschlange zur Moderation. Erst nachdem der Inhalt überprüft und für den Konsum geeignet befunden wurde, wird er auf der Plattform veröffentlicht. Obwohl dies eine sichere Methode zum Blockieren expliziter Inhalte ist, ist sie zeitaufwändig.

Nachmoderation

Post-Moderation ist die Standardmethode der Inhaltsmoderation, bei der ein Kompromiss zwischen Benutzerengagement und Moderation besteht. Obwohl Benutzer ihre Beiträge posten dürfen, werden sie immer noch zur Moderation in die Warteschlange gestellt. Wenn der Inhalt gemeldet wurde, wird er überprüft und entfernt. Unternehmen streben eine kürzere Überprüfungszeit an, damit unangemessene Inhalte nicht zu lange online bleiben.

Reaktive Moderation

Bei der reaktiven Moderation wird die Benutzergemeinschaft ermutigt, unangemessene Inhalte zu melden, die gegen die Gemeinschaft verstoßen Regeln und Richtlinien. Bei dieser Methode wird die Aufmerksamkeit der Community auf die Inhalte gelenkt, die moderiert werden müssen. Die anstößigen Inhalte können jedoch für längere Zeit auf der Plattform verbleiben.

Verteilte Moderation

Bei einer verteilten Moderationsmethode kann die Online-Community mithilfe eines Bewertungssystems Inhalte überprüfen, markieren und entfernen, die sie als anstößig und gegen Richtlinien verstoßend findet.

Automatisierte Moderation

Wie der Name schon sagt, verwendet die automatische Moderation verschiedene Tools und Systeme, um Wörter oder Sätze zu markieren und Beiträge abzulehnen. Es funktioniert, indem bestimmte verbotene Wörter, Bilder und Videos mithilfe von Algorithmen für maschinelles Lernen herausgefiltert werden.

Obwohl die technologiegestützte Moderation immer mehr an Bedeutung gewinnt, menschliche Mäßigung in der Überprüfung nicht außer Acht gelassen werden. Unternehmen verwenden idealerweise eine Kombination aus automatisierten Tools und menschlichen Moderatoren, zumindest für komplexe Situationen.

[Lesen Sie auch: Fallstudie – Inhaltsmoderation]

Wie hilft maschinelles Lernen bei der Moderation von Inhalten?

Mit mehr als 5 Milliarden Menschen, die das Internet nutzen, und über 4 Milliarden, die in sozialen Netzwerken aktiv sind, ist es nicht leicht, über die schiere Anzahl von Bildern, Texten, Videos, Posts und Nachrichten zu staunen, die täglich generiert werden. Diese Mammutinhalte müssen auf irgendeine Weise moderiert werden, damit Benutzer, die auf ihre Social-Media-Sites zugreifen, eine angenehme und bereichernde Erfahrung machen können.

Die Inhaltsmoderation entstand als Lösung zum Entfernen von Inhalten, die explizit, beleidigend, beleidigend, betrügerisch oder gegen das Markenethos verstoßen. Traditionell haben sich Unternehmen ausschließlich auf menschliche Moderatoren verlassen, um benutzergenerierte Online-Inhalte zu überprüfen, die auf ihren Plattformen veröffentlicht wurden. Die vollständige Abhängigkeit von menschlichen Moderatoren kann den Prozess jedoch zeitaufwändig, kostspielig und ineffizient machen.

Unternehmen setzen jetzt maschinelle Lernalgorithmen ein, um Inhalte automatisch und effizient zu moderieren. AI-powered Die Inhaltsmoderation hat den gesamten Prozess effizient, schneller, konsistenter und kostengünstiger gemacht.

Obwohl dieser Prozess menschliche Moderatoren nicht überflüssig macht – Mensch-in-the-Loophilft der Beitrag menschlicher Moderatoren bei der Bearbeitung komplexer Sachverhalte. Darüber hinaus verstehen menschliche Moderatoren Sprachnuancen, kulturelle Unterschiede und Zusammenhänge besser. Wenn automatisierte Tools mit Hilfe menschlicher Moderatoren verwendet werden, werden die psychologischen Auswirkungen der Exposition gegenüber auslösenden Inhalten reduziert.

Herausforderungen der Inhaltsmoderation

Eine weitere große Herausforderung bei der Entwicklung eines genauen Algorithmus zur Moderation von Inhalten ist die Sprache. Eine zuverlässige Anwendung zur Moderation von Inhalten sollte in der Lage sein, mehrere Sprachen zu erkennen und kulturelle Nuancen, soziale Kontexte und sprachliche Dynamik zu verstehen.

Da eine Sprache im Laufe der Zeit mehrere Veränderungen durchläuft, da bestimmte Wörter, die gestern harmlos waren, heute Berühmtheit erlangt haben könnten, muss das ML-Modell mit der sich verändernden Welt Schritt halten. Zum Beispiel könnte ein Aktgemälde explizit und voyeuristisch oder einfach nur Kunst sein.

Wie ein Stück Inhalt wahrgenommen oder als unangemessen erachtet wird, hängt vom Kontext ab. Und es ist wichtig, Konsistenz und Standards innerhalb Ihrer Plattform zu haben, damit Ihre Benutzer Ihren Moderationsbemühungen vertrauen können.

Ein typischer Benutzer versucht immer, Schlupflöcher in Ihren Richtlinien zu finden und Moderationsregeln zu umgehen. Ihr ML-Algorithmus sollte sich jedoch mit den sich ändernden Zeiten kontinuierlich weiterentwickeln können.

Schließlich ist es die Frage der Voreingenommenheit. Die Diversifizierung Ihrer Trainingsdatenbank und Trainingsmodelle zur Kontexterkennung ist von entscheidender Bedeutung. Auch wenn die Entwicklung eines zuverlässigen Content-Moderation-Algorithmus herausfordernd erscheinen mag, beginnt es damit, qualitativ hochwertige Trainingsdatensätze in die Hände zu bekommen.

Drittanbieter mit dem richtigen Fachwissen und Erfahrung in der Bereitstellung angemessener Trainingsdatensätze sind die richtigen Ausgangspunkte.

Jedes Unternehmen mit sozialer Präsenz braucht Spitzentechnologie Lösung zur Moderation von Inhalten das hilft, Kundenvertrauen und ein einwandfreies Kundenerlebnis aufzubauen. Um die Anwendung zu erstellen und Ihr maschinelles Lernmodell zu trainieren, benötigen Sie Zugriff auf eine qualitativ hochwertige Datenbank ohne Voreingenommenheit, die auf die neuesten linguistischen und marktspezifischen Inhaltstrends abgestimmt ist.

Mit unserer jahrelangen Erfahrung bei der Unterstützung von Unternehmen bei der Einführung von KI-Modellen, Saip bietet umfassende Datenerfassungssysteme, die den unterschiedlichsten Anforderungen an die Moderation von Inhalten gerecht werden.