Bildanmerkung und -beschriftung für Computer Vision

Der ultimative Einkaufsführer 2023

Computer Vision ist ein riesiges Thema und für Techpreneure und angehende Unternehmer ist es nicht möglich, sich in kurzer Zeit vollständig damit auszukennen. Insbesondere wenn sie ein auf Computer Vision basierendes Produkt entwickeln und nur eine begrenzte Zeit zur Markteinführung haben, benötigen sie umfangreiches und substanzielles Wissen über die Grundlagen von Computer Vision und Bildannotation, um über funktionale Kenntnisse zu verfügen und fundierte Entscheidungen zu treffen.

Dieser Leitfaden wählt Konzepte aus und präsentiert sie auf die einfachste Art und Weise, damit Sie eine gute Klarheit darüber haben, worum es geht. Es hilft Ihnen, eine klare Vorstellung davon zu haben, wie Sie Ihr Produkt entwickeln können, welche Prozesse dahinter stecken, welche technischen Details erforderlich sind und vieles mehr. Dieser Leitfaden ist also äußerst einfallsreich, wenn Sie:

Einleitung

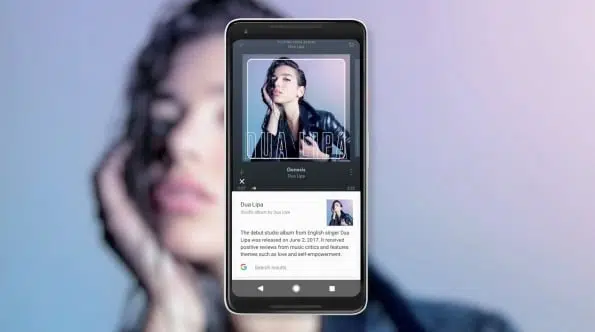

Haben Sie in letzter Zeit Google Lens verwendet? Nun, wenn Sie es nicht getan haben, werden Sie feststellen, dass die Zukunft, auf die wir alle gewartet haben, endlich da ist, wenn Sie beginnen, ihre wahnsinnigen Fähigkeiten zu erkunden. Die Entwicklung von Google Lens ist ein einfaches, ergänzendes Feature des Android-Ökosystems und beweist, wie weit wir in Bezug auf technologischen Fortschritt und Evolution gekommen sind.

Von der Zeit an, als wir nur auf unsere Geräte starrten und nur eine einseitige Kommunikation erlebten – vom Menschen bis zur Maschine, haben wir jetzt den Weg für eine nichtlineare Interaktion geebnet, bei der Geräte uns direkt anstarren, analysieren und verarbeiten können, was sie darin sehen Echtzeit.

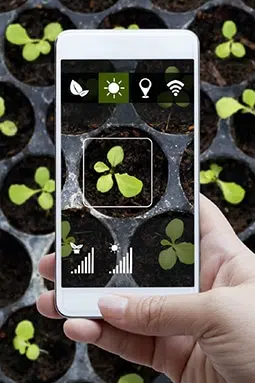

Sie nennen es Computer Vision und es dreht sich alles darum, was ein Gerät aus dem, was es durch seine Kamera sieht, verstehen und die Elemente der realen Welt verstehen kann. Um auf die Großartigkeit von Google Lens zurückzukommen, können Sie Informationen zu zufälligen Objekten und Produkten finden. Wenn Sie die Kamera Ihres Geräts einfach auf eine Maus oder eine Tastatur richten, sagt Ihnen Google Lens die Marke, das Modell und den Hersteller des Geräts.

Außerdem können Sie es auch auf ein Gebäude oder einen Ort zeigen und Details dazu in Echtzeit abrufen. Sie könnten Ihr mathematisches Problem scannen und Lösungen dafür finden, handschriftliche Notizen in Text umwandeln, Pakete durch einfaches Scannen verfolgen und mehr mit Ihrer Kamera tun, ohne jegliche Schnittstelle.

Computer Vision endet hier nicht. Sie hätten es auf Facebook gesehen, wenn Sie versuchen, ein Bild in Ihr Profil hochzuladen, und Facebook erkennt und markiert automatisch Gesichter von Ihnen und denen Ihrer Freunde und Familie. Computer Vision verbessert den Lebensstil der Menschen, vereinfacht komplexe Aufgaben und macht das Leben der Menschen einfacher.

Aber warum sagen wir das alles?

Es ist einfach. Es war nicht so einfach, zu dem Punkt zu gelangen, an dem wir uns gerade befinden. Wenn Google Lens ein Bild sofort erkennen und alles aus dem Internet herausholen konnte, brauchte es Jahre der Entwicklung und des Trainings. Der Erfolg von Computer Vision läuft vollständig auf das ab, was wir Bildannotation nennen – der grundlegende Prozess hinter der Technologie, der Computer und Geräte dazu bringt, intelligente und ideale Entscheidungen zu treffen.

Ohne Bildanmerkung kann es keine Computer Vision und die damit verbundenen Vorteile geben, und genau das werden wir in diesem ausführlichen Handbuch besprechen und untersuchen. Von den Grundlagen der Bildanmerkung bis hin zur Suche nach den richtigen Anbietern werden wir alle Aspekte untersuchen. Dies wird Ihnen helfen, ein besseres Produkt zu entwickeln und letztendlich Ihr Wissen über Machine Learning- und Deep-Learning-Module zu erweitern.

Was ist Bildanmerkung?

Lass uns ehrlich sein. Computer sind einfach und ziemlich dumm. Sie müssen mit Löffel gefütterte Anweisungen zur Ausführung von Aufgaben sein. Erst vor kurzem haben Fortschritte es Maschinen ermöglicht, durch künstliche Intelligenz, maschinelles Lernen und Deep Learning die Fähigkeit zu entwickeln, autonom zu denken und die besten Wege zur Lösung eines Problems zu finden.

Wenn ein ungeübtes Gerät das Bild einer Palme betrachtet, weiß es nicht, was es ist. Sein Wissen ähnelt fast dem eines Säuglings, der noch nicht gelernt hat, was ein Baum ist. Maschinen müssen lernen, was ein Baum ist und welche Baumarten es gibt.

Bildannotationen sind eine Teilmenge der Datenkennzeichnung, die auch unter dem Namen Image-Tagging, Transkription oder Labeling bekannt ist, bei der Menschen am Back-End unermüdlich Bilder mit Metadateninformationen und Attributen versehen, die Maschinen helfen, Objekte besser zu identifizieren. Betrachtet man das gleiche Beispiel für Bäume, widmen Experten für maschinelles Lernen einen Großteil ihrer Zeit der Kommentierung von Bildern von Bäumen und geben an, was eine Palme ist und wie sie aussieht. Auf diese Weise kann ein Gerät Palmen genau erkennen.

Der Prozess ist jedoch noch nicht abgeschlossen. Es mag den Anschein haben, dass Maschinen inzwischen die Erkennung von Palmen beherrschen, aber erst wenn Sie ihnen das Bild einer Weide zeigen, werden Sie feststellen, dass die Maschine noch nicht bereit ist. Experten müssen also Bilder mit Anmerkungen versehen, um Maschinen anzuweisen, was Palmen auch „nicht“ sind. Durch kontinuierliches Training über Jahre hinweg lernen Maschinen, Objekte je nach Nische, Zweck und Datensätzen nahtlos zu erkennen und zu identifizieren.

Bildanmerkung für Computer Vision

Bildannotation ist eine Teilmenge der Datenbeschriftung, die auch unter dem Namen Image-Tagging, Transkription oder Beschriftung bekannt ist. Bei der Bildannotation sind Menschen am Backend beteiligt, die unermüdlich Bilder mit Metadateninformationen und Attributen versehen, die Maschinen helfen, Objekte besser zu identifizieren.

Bilddaten

- 2-D-Bilder

- 3-D-Bilder

Arten von Anmerkungen

- Bildklassifizierung

- Objekterkennung

- Bildsegmentierung

- Objektüberwachung

- Bildtranskription

Anmerkungstechniken

- Begrenzungsrahmen

- Polyline

- Vieleck

- Wahrzeichen-Anmerkung

Welche Bilder können mit Anmerkungen versehen werden?

- Bilder und Bilder mit mehreren Frames, dh Videos, können für maschinelles Lernen gekennzeichnet werden. Die gängigsten Typen sind:

- 2-D- und Multi-Frame-Bilder (Video), dh Daten von Kameras oder SLRs oder einem optischen Mikroskop usw.

- 3-D- und Multi-Frame-Bilder (Video), dh Daten von Kameras oder Elektronen-, Ionen- oder Rastersondenmikroskopen usw.

Welche Details werden einem Bild während der Anmerkung hinzugefügt?

Alle Informationen, die es Maschinen ermöglichen, besser zu verstehen, was ein Bild enthält, werden von Experten kommentiert. Dies ist eine äußerst arbeitsintensive Aufgabe, die unzählige Stunden manueller Arbeit erfordert.

Was die Details betrifft, hängt es von den Projektspezifikationen und Anforderungen ab. Wenn das Projekt erfordert, dass das Endprodukt nur ein Bild klassifiziert, werden entsprechende Informationen hinzugefügt. Wenn es bei Ihrem Computer-Vision-Produkt beispielsweise darum geht, Ihren Benutzern zu sagen, dass es sich bei dem, was sie scannen, um einen Baum handelt, und ihn von einer Schlingpflanze oder einem Strauch zu unterscheiden, wäre das kommentierte Detail nur ein Baum.

Wenn die Projektanforderungen jedoch komplex sind und mehr Einblicke erfordern, die mit Benutzern geteilt werden müssen, würde die Annotation die Aufnahme von Details wie dem Namen des Baums, seinem botanischen Namen, den Boden- und Wetteranforderungen, der idealen Wachstumstemperatur und mehr beinhalten.

Mit diesen Informationen analysieren und verarbeiten Maschinen Eingaben und liefern den Endbenutzern genaue Ergebnisse.

Arten von Bildanmerkungen

Ein Bild enthält normalerweise mehrere Elemente. Sie könnten sich auf ein bestimmtes Motiv oder ein Objekt konzentrieren, aber Sie haben immer noch andere Elemente in Ihrem Bild. Manchmal sind diese Objekte für die Analyse erforderlich, und manchmal müssen sie eliminiert werden, um Fälle von Verzerrungen oder Datenverzerrungen beiseite zu halten. Unabhängig von der Instanz müssen Maschinen alle Elemente in einem Bild kennen, um ihre eigenen Entscheidungen zu treffen. Bei der Bildannotation werden auch andere Objekte identifiziert. Obwohl dies von Projekt zu Projekt unterschiedlich ist, ist es gut, eine Vorstellung von den verschiedenen Bildanmerkungsfunktionen zu haben.

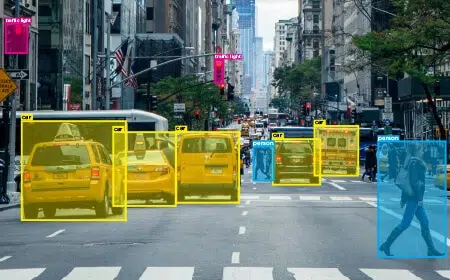

Um die Visualisierung zu erhalten, verwenden wir das folgende Bild als Referenz. Wenn Sie bemerken, sieht das Bild einfach und klar aus, aber achten Sie auf die Anzahl der verschiedenen Elemente darin. Sie haben Autos, Gebäude, Fußgängerüberwege, Ampeln und mehr. Wenn Sie es weiter verfeinern, gibt es Taxis und private Fahrzeuge, Gebäude und Wolkenkratzer, Schilder und mehr. Bei der Bildanmerkung geht es darum, ins Detail zu gehen.

Arten von Bildanmerkungen

Bildklassifizierung

Der einfachste Typ, bei dem Objekte grob klassifiziert werden. Hier besteht der Prozess also nur darin, Elemente wie Fahrzeuge, Gebäude und Ampeln zu identifizieren.

Objekterkennung

Eine etwas spezifischere Funktion, bei der verschiedene Objekte identifiziert und kommentiert werden. Fahrzeuge können Autos und Taxis, Gebäude und Wolkenkratzer sowie die Spuren 1, 2 oder mehr sein.

Bildsegmentierung

Dies geht auf die Besonderheiten jedes Bildes ein. Es beinhaltet das Hinzufügen von Informationen über ein Objekt, dh Farbe, Standorterscheinung usw., um Maschinen bei der Unterscheidung zu helfen. Das Fahrzeug in der Mitte wäre beispielsweise ein gelbes Taxi auf Spur 2.

Objektüberwachung

Dabei werden die Details eines Objekts wie Standort und andere Attribute über mehrere Frames im selben Datensatz identifiziert. Filmmaterial von Videos und Überwachungskameras kann für Objektbewegungen und Untersuchungsmuster verfolgt werden.

Bildanmerkungstechniken

Die Bildannotation erfolgt durch verschiedene Techniken und Prozesse. Um mit der Bildannotation zu beginnen, benötigt man eine Softwareanwendung, die die spezifischen Funktionen und Funktionen bietet, sowie Tools, die zum Annotieren von Bildern basierend auf Projektanforderungen erforderlich sind.

Für Uneingeweihte gibt es mehrere im Handel erhältliche Bildanmerkungstools, mit denen Sie sie für Ihren speziellen Anwendungsfall ändern können. Es gibt auch Tools, die Open Source sind. Wenn Ihre Anforderungen jedoch Nischen sind und Sie der Meinung sind, dass die von kommerziellen Tools angebotenen Module zu einfach sind, können Sie ein benutzerdefiniertes Bildanmerkungstool für Ihr Projekt entwickeln. Dies ist natürlich teurer und zeitaufwendiger.

Unabhängig davon, welches Tool Sie erstellen oder abonnieren, gibt es bestimmte universelle Bildanmerkungstechniken. Schauen wir uns an, was sie sind.

Begrenzungsrahmen

Bei der grundlegendsten Bildannotationstechnik zeichnen Experten oder Kommentatoren einen Rahmen um ein Objekt, um objektspezifische Details zuzuordnen. Diese Technik ist am besten geeignet, um Objekte mit symmetrischer Form mit Anmerkungen zu versehen.

Eine weitere Variation von Bounding Boxes sind Quader. Dies sind 3D-Varianten von Bounding Boxes, die normalerweise zweidimensional sind. Quader verfolgen Objekte über ihre Dimensionen, um genauere Details zu erhalten. Wenn Sie das obige Bild betrachten, könnten die Fahrzeuge leicht durch Begrenzungsrahmen kommentiert werden.

Um Ihnen eine bessere Vorstellung zu geben, geben Ihnen 2D-Boxen Details zur Länge und Breite eines Objekts. Die Quadertechnik gibt Ihnen jedoch auch Details zur Tiefe des Objekts. Das Annotieren von Bildern mit Quadern wird schwieriger, wenn ein Objekt nur teilweise sichtbar ist. In solchen Fällen approximieren Annotatoren die Kanten und Ecken eines Objekts basierend auf vorhandenen Bildern und Informationen.

Sehenswürdigkeiten

Diese Technik wird verwendet, um die Feinheiten der Bewegungen von Objekten in einem Bild oder Filmmaterial hervorzuheben. Sie können auch verwendet werden, um kleine Objekte zu erkennen und zu beschriften. Landmarking wird speziell verwendet in Gesichtserkennung zu kommentierten Gesichtszügen, Gesten, Mimik, Körperhaltung und mehr. Es beinhaltet die individuelle Identifizierung von Gesichtsmerkmalen und deren Attributen, um genaue Ergebnisse zu erzielen.

Um Ihnen ein praktisches Beispiel dafür zu geben, wo Landmarking nützlich ist, denken Sie an Ihre Instagram- oder Snapchat-Filter, die Hüte, Schutzbrillen oder andere lustige Elemente basierend auf Ihren Gesichtszügen und Ausdrücken genau platzieren. Wenn Sie also das nächste Mal für einen Hundefilter posieren, sollten Sie verstehen, dass die App Ihre Gesichtszüge für präzise Ergebnisse markiert hat.

Polygone

Objekte in Bildern sind nicht immer symmetrisch oder regelmäßig. Es gibt unzählige Fälle, in denen Sie feststellen, dass sie unregelmäßig oder einfach nur zufällig sind. In solchen Fällen setzen Annotatoren die Polygontechnik ein, um unregelmäßige Formen und Objekte präzise mit Anmerkungen zu versehen. Diese Technik beinhaltet das Platzieren von Punkten über die Abmessungen eines Objekts und das manuelle Zeichnen von Linien entlang des Umfangs oder Umfangs des Objekts.

Linien

Neben Grundformen und Polygonen werden auch einfache Linien zur Beschriftung von Objekten in Bildern verwendet. Diese Technik ermöglicht es Maschinen, Grenzen nahtlos zu erkennen. Beispielsweise werden für Maschinen in autonomen Fahrzeugen Linien über Fahrspuren gezogen, um die Grenzen, innerhalb derer sie manövrieren müssen, besser zu verstehen. Linien werden auch verwendet, um diese Maschinen und Systeme für verschiedene Szenarien und Umstände zu trainieren und ihnen zu helfen, bessere Fahrentscheidungen zu treffen.

Anwendungsfälle für Bildanmerkungen

In diesem Abschnitt wird erläutert, wie Bildanmerkungen oder Bildbeschriftungen verwendet werden können, um ML-Modelle zu trainieren, um bestimmte Aufgaben basierend auf ihrer jeweiligen Branche auszuführen.

Einzelhandel: In einem Einkaufszentrum oder einem Lebensmittelgeschäft kann die 2-D-Bounding-Box-Technik verwendet werden, um Bilder von Produkten im Geschäft, z. B. Hemden, Hosen, Jacken, Personen usw. Design usw

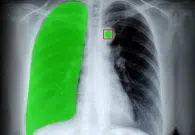

Gesundheitswesen: Die Polygon-Technik kann verwendet werden, um menschliche Organe in medizinischen Röntgenaufnahmen zu kommentieren/zu beschriften, um ML-Modelle zu trainieren, um Missbildungen in der menschlichen Röntgenaufnahme zu identifizieren. Dies ist einer der kritischsten Anwendungsfälle, der die Gesundheitswesen durch die Identifizierung von Krankheiten, die Reduzierung von Kosten und die Verbesserung der Patientenerfahrung.

Selbstfahrende Autos: Wir haben den Erfolg des autonomen Fahrens bereits gesehen, aber wir haben noch einen langen Weg vor uns. Viele Autohersteller müssen die besagte Technologie noch übernehmen, die auf einer semantischen Segmentierung beruht, die jedes Pixel auf einem Bild kennzeichnet, um die Straße, Autos, Ampeln, Masten, Fußgänger usw spüren Hindernisse auf ihrem Weg.

Emotionserkennung: Landmark-Annotation wird verwendet, um menschliche Emotionen/Gefühle (glücklich, traurig oder neutral) zu erkennen, um den emotionalen Gemütszustand des Subjekts bei einem bestimmten Inhalt zu messen. Emotionserkennung oder Sentiment-Analyse kann für Produktbewertungen, Servicebewertungen, Filmbewertungen, E-Mail-Beschwerden/Feedbacks, Kundenanrufe und Besprechungen usw. verwendet werden.

Lieferkette: Linien und Splines werden verwendet, um Gassen in einem Lager zu kennzeichnen, um Regale anhand ihres Lieferortes zu identifizieren. Dies wiederum hilft den Robotern, ihren Weg zu optimieren und die Lieferkette zu automatisieren, wodurch menschliche Eingriffe und Fehler minimiert werden.

Wie gehen Sie bei der Bildanmerkung vor: Inhouse vs. Outsourcing?

Die Bildannotation erfordert nicht nur Investitionen in Geld, sondern auch in Zeit und Aufwand. Wie bereits erwähnt, ist es arbeitsintensiv, das eine sorgfältige Planung und ein sorgfältiges Engagement erfordert. Was Bildannotatoren zuschreiben, ist, was die Maschinen verarbeiten und Ergebnisse liefern. Daher ist die Bildannotationsphase äußerst entscheidend.

Aus geschäftlicher Sicht haben Sie nun zwei Möglichkeiten, Ihre Bilder mit Anmerkungen zu versehen –

- Du kannst es im Haus machen

- Oder Sie können den Prozess auslagern

Beide sind einzigartig und bieten ihren eigenen fairen Anteil an Vor- und Nachteilen. Betrachten wir sie objektiv.

In-house

Dabei kümmern sich Ihr bestehender Talentpool oder Teammitglieder um Bildannotationsaufgaben. Die interne Technik setzt voraus, dass Sie über eine Datengenerierungsquelle verfügen, über das richtige Werkzeug oder Datenanmerkung Plattform und das richtige Team mit den entsprechenden Fähigkeiten zur Durchführung von Annotationsaufgaben.

Dies ist perfekt, wenn Sie ein Unternehmen oder eine Unternehmenskette sind, die in dedizierte Ressourcen und Teams investieren können. Als Unternehmen oder Marktteilnehmer mangelt es Ihnen auch nicht an Datensätzen, die für den Beginn Ihrer Schulungsprozesse entscheidend sind.

Outsourcing

Dies ist eine weitere Möglichkeit, Bildanmerkungsaufgaben zu erledigen, bei der Sie die Aufgabe einem Team übertragen, das über die erforderliche Erfahrung und das erforderliche Fachwissen verfügt, um sie auszuführen. Sie müssen ihnen nur Ihre Anforderungen und eine Frist mitteilen, und sie stellen sicher, dass Sie Ihre Ergebnisse rechtzeitig erhalten.

Das ausgelagerte Team könnte sich in derselben Stadt oder Nachbarschaft wie Ihr Unternehmen oder an einem völlig anderen geografischen Standort befinden. Was beim Outsourcing zählt, ist der praktische Umgang mit dem Job und das Wissen, wie man Bilder annotiert.

Bildkommentar: Outsourcing vs. Inhouse-Teams – Alles, was Sie wissen müssen

| Outsourcing | In-house |

|---|---|

| Wenn ein Projekt an ein anderes Team ausgelagert wird, müssen zusätzliche Klauseln und Protokolle implementiert werden, um die Datenintegrität und Vertraulichkeit zu gewährleisten. | Bewahren Sie die Vertraulichkeit von Daten nahtlos, wenn Sie über dedizierte interne Ressourcen verfügen, die an Ihren Datensätzen arbeiten. |

| Sie können die gewünschten Bilddaten anpassen. | Sie können Ihre Datengenerierungsquellen an Ihre Bedürfnisse anpassen. |

| Sie müssen keine zusätzliche Zeit damit verbringen, Daten zu bereinigen und dann daran zu arbeiten, sie mit Anmerkungen zu versehen. | Sie müssen Ihre Mitarbeiter bitten, zusätzliche Stunden damit zu verbringen, Rohdaten zu bereinigen, bevor sie mit Anmerkungen versehen werden. |

| Es gibt keine Überlastung der Ressourcen, da Sie den Prozess, die Anforderungen und den Plan vor der Zusammenarbeit vollständig ausgearbeitet haben. | Am Ende überlasten Sie Ihre Ressourcen, da die Datenannotation eine zusätzliche Verantwortung in ihren vorhandenen Rollen ist. |

| Termine werden immer ohne Kompromisse bei der Datenqualität eingehalten. | Fristen können sich verlängern, wenn Sie weniger Teammitglieder und mehr Aufgaben haben. |

| Ausgelagerte Teams sind anpassungsfähiger an neue Richtlinienänderungen. | Senkt die Moral der Teammitglieder jedes Mal, wenn Sie von Ihren Anforderungen und Richtlinien abweichen. |

| Sie müssen keine Datengenerierungsquellen pflegen. Das Endprodukt erreicht Sie pünktlich. | Sie sind für die Generierung der Daten verantwortlich. Benötigt Ihr Projekt Millionen von Bilddaten, liegt es an Ihnen, entsprechende Datensätze zu beschaffen. |

| Die Skalierbarkeit der Arbeitsbelastung oder der Teamgröße ist nie ein Problem. | Skalierbarkeit ist ein wichtiges Anliegen, da schnelle Entscheidungen nicht nahtlos getroffen werden können. |

Fazit

Wie Sie deutlich sehen können, ist es zwar bequemer, ein internes Bild-/Datenannotationsteam zu haben, aber das Outsourcing des gesamten Prozesses ist auf lange Sicht rentabler. Wenn Sie mit engagierten Experten zusammenarbeiten, entlasten Sie sich von vielen Aufgaben und Verantwortlichkeiten, die Sie gar nicht erst tragen mussten. Lassen Sie uns mit diesem Verständnis weiter erkennen, wie Sie die richtigen Anbieter oder Teams für Datenanmerkungen finden können.

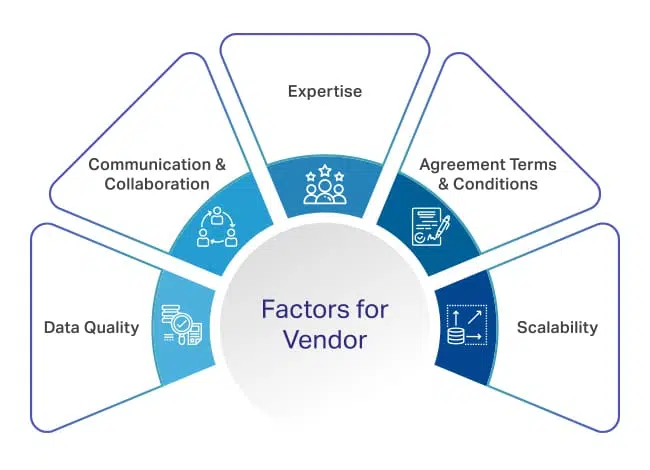

Faktoren, die bei der Auswahl eines Anbieters von Datenanmerkungen zu berücksichtigen sind

Dies ist eine große Verantwortung und die gesamte Leistung Ihres Machine Learning-Moduls hängt von der Qualität der von Ihrem Anbieter gelieferten Datensätze und dem Timing ab. Deshalb sollten Sie vor der Vertragsunterzeichnung mehr darauf achten, mit wem Sie sprechen, was sie versprechen und weitere Faktoren berücksichtigen.

Um Ihnen den Einstieg zu erleichtern, sind hier einige entscheidende Faktoren, die Sie berücksichtigen sollten.

Expertise

Einer der wichtigsten zu berücksichtigenden Faktoren ist die Expertise des Anbieters oder Teams, das Sie für Ihr Machine-Learning-Projekt einstellen möchten. Das Team, das Sie auswählen, sollte die meisten praktischen Erfahrungen haben Datenanmerkung Tools, Techniken, Domänenwissen und Erfahrung in der Arbeit in mehreren Branchen.

Neben den technischen Aspekten sollten sie auch Methoden zur Workflow-Optimierung implementieren, um eine reibungslose Zusammenarbeit und eine konsistente Kommunikation zu gewährleisten. Für mehr Verständnis fragen Sie sie zu den folgenden Aspekten:

- Die vorherigen Projekte, an denen sie gearbeitet haben und die Ihrem ähnlich sind

- Die jahrelange Erfahrung, die sie haben

- Das Arsenal an Tools und Ressourcen, die sie für die Annotation bereitstellen

- Ihre Methoden, um eine konsistente Datenannotation und pünktliche Lieferung zu gewährleisten

- Wie komfortabel oder vorbereitet sie in Bezug auf Projektskalierbarkeit und mehr sind

Datenqualität

Die Datenqualität beeinflusst den Projektoutput direkt. All Ihre Jahre der Arbeit, des Netzwerkens und der Investitionen hängen von der Leistung Ihres Moduls vor der Einführung ab. Stellen Sie also sicher, dass die Anbieter, mit denen Sie zusammenarbeiten möchten, die qualitativ hochwertigsten Datensätze für Ihr Projekt liefern. Damit Sie eine bessere Vorstellung davon bekommen, ist hier ein kurzer Spickzettel, den Sie sich ansehen sollten:

- Wie misst Ihr Anbieter die Datenqualität? Was sind die Standardkennzahlen?

- Details zu ihren Qualitätssicherungsprotokollen und Beschwerdeverfahren

- Wie stellen sie den Wissenstransfer von einem Teammitglied zum anderen sicher?

- Können sie die Datenqualität aufrechterhalten, wenn das Volumen nachträglich erhöht wird?

Kommunikation und Zusammenarbeit

Die Bereitstellung qualitativ hochwertiger Ergebnisse führt nicht immer zu einer reibungslosen Zusammenarbeit. Dazu gehört auch eine nahtlose Kommunikation und eine hervorragende Aufrechterhaltung der Beziehung. Sie können nicht mit einem Team arbeiten, das Ihnen während des gesamten Verlaufs der Zusammenarbeit kein Update gibt oder Sie aus der Schleife heraushält und plötzlich ein Projekt zum Zeitpunkt der Deadline liefert.

Aus diesem Grund ist eine Ausgewogenheit unerlässlich und Sie sollten deren Arbeitsweise und allgemeine Einstellung zur Zusammenarbeit genau beachten. Stellen Sie also Fragen zu ihren Kommunikationsmethoden, der Anpassungsfähigkeit an Richtlinien und Anforderungsänderungen, der Reduzierung von Projektanforderungen und mehr, um eine reibungslose Reise für beide Beteiligten zu gewährleisten.

Vertragsbedingungen

Abgesehen von diesen Aspekten gibt es einige Aspekte und Faktoren, die in Bezug auf Gesetzlichkeiten und Vorschriften unvermeidlich sind. Dazu gehören Preiskonditionen, Dauer der Zusammenarbeit, Assoziationsbedingungen, Zuweisung und Spezifizierung von Jobrollen, klar definierte Grenzen und mehr.

Sortieren Sie sie, bevor Sie einen Vertrag unterschreiben. Um Ihnen eine bessere Vorstellung zu geben, ist hier eine Liste von Faktoren:

- Erkundigen Sie sich nach Zahlungsbedingungen und Preismodell – ob die Preise für die geleistete Arbeit pro Stunde oder pro Anmerkung gelten

- Ist die Auszahlung monatlich, wöchentlich oder XNUMX-tägig?

- Der Einfluss von Preismodellen bei Änderung der Projektrichtlinien oder des Arbeitsumfangs

Skalierbarkeit

Ihr Geschäft wird in Zukunft wachsen und der Umfang Ihres Projekts wird exponentiell wachsen. In solchen Fällen sollten Sie sicher sein, dass Ihr Anbieter die von Ihrem Unternehmen benötigten Mengen an beschrifteten Bildern in großem Maßstab liefern kann.

Haben sie genug Talente im Haus? Erschöpfen sie alle ihre Datenquellen? Können sie Ihre Daten an individuelle Bedürfnisse und Anwendungsfälle anpassen? Aspekte wie diese stellen sicher, dass der Anbieter umsteigen kann, wenn höhere Datenmengen erforderlich sind.

Fazit

Wenn Sie diese Faktoren berücksichtigen, können Sie sicher sein, dass Ihre Zusammenarbeit reibungslos und reibungslos verläuft und wir empfehlen, Ihre Bildannotationsaufgaben an die Spezialisten auszulagern. Halten Sie Ausschau nach führenden Unternehmen wie Saip, die alle in der Anleitung erwähnten Kästchen ankreuzen.

Wir sind seit Jahrzehnten im Bereich der künstlichen Intelligenz tätig und haben die Entwicklung dieser Technologie miterlebt. Wir wissen, wie es begann, wie es läuft und wie es weitergeht. So halten wir uns nicht nur über die neuesten Entwicklungen auf dem Laufenden, sondern bereiten uns auch auf die Zukunft vor.

Außerdem wählen wir Experten aus, um sicherzustellen, dass Daten und Bilder mit höchster Präzision für Ihre Projekte annotiert werden. Egal wie Nische oder Einzigartig Ihr Projekt ist, seien Sie sich immer sicher, dass Sie von uns eine einwandfreie Datenqualität erhalten.

Sprechen Sie uns einfach an und besprechen Sie Ihre Anforderungen und wir legen sofort los. Melden Sie sich mit uns heute.

diskutieren

Häufig gestellte Fragen (FAQ)

Bildannotationen sind eine Teilmenge der Datenkennzeichnung, die auch unter dem Namen Image-Tagging, Transkription oder Labeling bekannt ist, bei der Menschen am Backend beteiligt sind und Bilder unermüdlich mit Metadateninformationen und Attributen versehen, die Maschinen helfen, Objekte besser zu identifizieren.

An Bildanmerkungs-/Beschriftungstool ist eine Software, die verwendet werden kann, um Bilder mit Metadateninformationen und Attributen zu versehen, die Maschinen helfen, Objekte besser zu identifizieren.

Bildkennzeichnungs-/Anmerkungsdienste sind Dienste, die von Drittanbietern angeboten werden, die ein Bild in Ihrem Namen kennzeichnen oder mit Anmerkungen versehen. Sie bieten die erforderliche Expertise, Qualitätsagilität und Skalierbarkeit bei Bedarf.

Ein beschriftetes/kommentiertes Bild ist eine, die mit Metadaten versehen wurde, die das Bild beschreiben und es durch maschinelle Lernalgorithmen verständlich machen.

Bildannotation für maschinelles Lernen oder Deep Learning ist das Hinzufügen von Beschriftungen oder Beschreibungen oder das Klassifizieren eines Bildes, um die Datenpunkte anzuzeigen, die Ihr Modell erkennen soll. Kurz gesagt, es fügt relevante Metadaten hinzu, um es für Maschinen erkennbar zu machen.

Bildanmerkung beinhaltet die Verwendung einer oder mehrerer dieser Techniken: Bounding Boxes (2-d,3-d), Landmarking, Polygone, Polylinien usw.