Künstliche Intelligenz revolutioniert die Musikindustrie und bietet automatisierte Kompositions-, Mastering- und Performance-Tools. KI-Algorithmen generieren neuartige Kompositionen, sagen Hits voraus und personalisieren das Hörerlebnis und verändern so die Musikproduktion, den Vertrieb und den Konsum. Diese neue Technologie bietet sowohl spannende Möglichkeiten als auch herausfordernde ethische Dilemmata.

Modelle für maschinelles Lernen (ML) erfordern Trainingsdaten, um effektiv zu funktionieren, so wie ein Komponist Noten benötigt, um eine Symphonie zu schreiben. In der Musikwelt, in der Melodie, Rhythmus und Emotionen ineinandergreifen, kann die Bedeutung hochwertiger Trainingsdaten nicht genug betont werden. Es ist das Rückgrat der Entwicklung robuster und genauer Musik-ML-Modelle für prädiktive Analysen, Genreklassifizierung oder automatische Transkription.

Daten, das Lebenselixier von ML-Modellen

Maschinelles Lernen ist von Natur aus datengesteuert. Diese Rechenmodelle lernen Muster aus den Daten und können so Vorhersagen oder Entscheidungen treffen. Bei Musik-ML-Modellen liegen die Trainingsdaten häufig in Form digitalisierter Musiktitel, Liedtexte, Metadaten oder einer Kombination dieser Elemente vor. Die Qualität, Quantität und Vielfalt dieser Daten hat erheblichen Einfluss auf die Wirksamkeit des Modells.

Qualität: Die Harmonie der Daten

Qualität ist ein entscheidender Aspekt jedes Trainingsdatensatzes. Hochwertige Daten für Musik-ML-Modelle bedeuten, dass sie präzise und ohne Rauschen oder Fehler gekennzeichnet sind. Wenn ein Modell beispielsweise darauf abzielt, Musikgenres zu klassifizieren, sollten die Trainingsdaten korrekt mit den jeweiligen Genres gekennzeichnet werden. Jede falsche Beschriftung kann das Modell irreführen und zu einer schlechten Leistung führen. Darüber hinaus sollten die Audiodateien frei von Fremdgeräuschen sein, um sicherzustellen, dass das Modell die richtigen Funktionen lernt.

Quantität: Die Skala des Lernens

Die Größe des Trainingsdatensatzes spielt eine wichtige Rolle für die Lernfähigkeit eines Modells. Grundsätzlich gilt: Je mehr Daten, desto besser. ML-Modelle benötigen erhebliche Datenmengen, um gut verallgemeinern zu können. Ein großer und vielfältiger Datensatz setzt das Modell zahlreichen Szenarien aus und verringert so die Wahrscheinlichkeit einer Überanpassung, bei der das Modell die Trainingsdaten zu gut lernt und bei unsichtbaren Daten keine effektive Leistung erbringt.

Vielfalt: Der Rhythmus der Varianz

So wie ein Musikstück von Variation lebt, ist die Vielfalt des Trainingsdatensatzes von größter Bedeutung. Ein vielfältiger Datensatz umfasst Musik aus verschiedenen Genres, Sprachen und kulturellen Hintergründen. Diese Vielfalt trägt dazu bei, dass das ML-Modell vielseitig und robust ist und ein breites Spektrum an Musikarten verarbeiten kann, nicht nur die, auf die es hauptsächlich trainiert wurde.

Der Weg zum Maestro-Modell

Um Qualität, Quantität und Vielfalt der Trainingsdaten zu erreichen, sind sorgfältige Datenerfassungs-, Kennzeichnungs- und Erweiterungsprozesse erforderlich. Die Investition ist beträchtlich, aber die Rendite ist ebenso lohnend. Ein gut trainiertes Musik-ML-Modell kann verschiedene Aspekte der Musikindustrie verändern, von der Verbesserung der Musikentdeckung bis hin zur Automatisierung von Komposition und Mastering.

Letztendlich bestimmt die Qualität der Trainingsdaten, wie effektiv ein Musik-ML-Modell funktioniert. Daher trägt, wie die Bedeutung jeder Note in einer Symphonie, jedes bisschen Trainingsdaten zum Meisterwerk bei, das ein gut trainiertes, zuverlässiges und genaues ML-Modell in der Musikindustrie ist.

Anwendungsfälle für Musik-KI

Komposition

KI-Algorithmen wie MuseNet von OpenAI können Originalmusik erstellen, indem sie Muster und Stile bestehender Musik analysieren. Dies hilft Musikern, neue Ideen zu entwickeln oder Hintergrundtracks für verschiedene Zwecke zu produzieren.

Auto-Tagging

Dabei handelt es sich um den Prozess der automatischen Zuweisung relevanter Metadaten oder Tags zu einem Musikstück, was zur Verbesserung der Durchsuchbarkeit, Organisation und Empfehlung beitragen kann.

Musikempfehlung

KI-Algorithmen wie MuseNet von OpenAI können Originalmusik erstellen, indem sie Muster und Stile bestehender Musik analysieren. Dies hilft Musikern, neue Ideen zu entwickeln oder Hintergrundtracks für verschiedene Zwecke zu produzieren.

Urheberrechtserkennung

KI kann urheberrechtlich geschützte Musikinhalte identifizieren und Plattformen dabei helfen, Lizenzvereinbarungen durchzusetzen und Zahlungen an Künstler sicherzustellen.

Musikkategorisierung

Automatisches Tagging kann dabei helfen, Musiktitel nach Genre, Stimmung, Tempo, Tonart und anderen Attributen zu klassifizieren und so den Hörern das Suchen und Entdecken neuer Musik zu erleichtern.

Erstellung einer Wiedergabeliste

Durch die Analyse und Kategorisierung von Musik mit Auto-Tagging können Streaming-Dienste automatisch Playlists erstellen, die auf die Vorlieben der Benutzer oder bestimmte Themen eingehen, wie zum Beispiel Workout-Playlists oder Lern-Playlists.

Musiklizenzierung

Musikbibliotheken und Lizenzplattformen können Auto-Tagging nutzen, um ihren Katalog zu organisieren und es Kunden einfacher zu machen, den richtigen Titel für ihre Projekte zu finden, etwa Werbung, Filme oder Videospiele.

Wie Shaip hilft

Shaip bietet Datenerfassungs- und Transkriptionsdienste zur Erstellung von ML-Modellen für die Musikindustrie an. Unser professionelles Musiksammlungs- und Transkriptionsservice-Team ist auf das Sammeln und Transkribieren von Musik spezialisiert, um Sie bei der Erstellung von ML-Modellen zu unterstützen.

Unsere umfassenden Lösungen liefern hochwertige, vielfältige Daten aus verschiedenen Quellen und ebnen den Weg für bahnbrechende Anwendungen in der Musikempfehlung, Komposition, Transkription und Emotionsanalyse. Entdecken Sie diese Broschüre, um zu erfahren, wie unser sorgfältiger Datenverwaltungsprozess und unsere erstklassigen Transkriptionsdienste Ihre Reise zum maschinellen Lernen beschleunigen und Ihnen einen Wettbewerbsvorteil in der heutigen schnelllebigen Musiklandschaft verschaffen können. Verwirklichen Sie Ihre musikalischen Ambitionen mit unserem beispiellosen Fachwissen und unserem Engagement für Spitzenleistungen.

Datensammlung

Erschließen Sie die Zukunft des Musikgeschäfts, indem Sie die Leistungsfähigkeit der künstlichen Intelligenz (KI) mit unseren umfassenden KI-Trainingsdaten für die Musikindustrie nutzen. Unser sorgfältig kuratierter Datensatz ermöglicht es Modellen des maschinellen Lernens, umsetzbare Erkenntnisse zu generieren und so die Art und Weise, wie Sie die Musiklandschaft verstehen und mit ihr interagieren, zu revolutionieren. Wir können Ihnen dabei helfen, Musikdaten aus den folgenden Bereichen mit zusätzlichen Kriterien zu sammeln, wie zum Beispiel:

| Musikgenres | Referentenkompetenz | Unterstützte Sprachen | Diversität |

|---|---|---|---|

| Pop, Rock, Jazz, Klassik, Country, Hip-Hop/Rap, Folk, Heavy Metal, Disco und mehr. | Anfänger, Mittelstufe, Profi | Englisch, Hindi, Tamil, Arabisch usw. | Männlich, weiblich, Kinder. |

Datentranskription

Unser Prozess, der auch als Datenanmerkung oder -kennzeichnung bezeichnet wird, umfasst die manuelle Eingabe der Partitur in eine spezielle Software, sodass Kunden auf die geschriebene Musik und eine begleitende MP3-Audiodatei zugreifen können, die die Partitur simuliert, während ein Computer spielt. Wir können den Part jedes Instruments genau erfassen, indem wir auf talentierte Musiktranskriptoren mit perfekter Tonhöhe zurückgreifen. Unser umfangreiches Fachwissen ermöglicht es uns, vielfältige Musikpartituren zu erstellen, die von einfachen Leadsheet-Transkriptionen bis hin zu komplexen Jazz-, Klavier- oder Orchesterkompositionen mit zahlreichen Instrumenten reichen. Einige Anwendungsfälle der Musiktranskription oder -kennzeichnung sind.

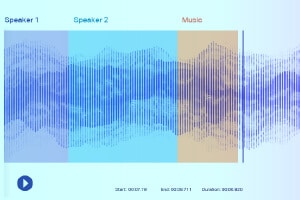

Sound-Beschriftung

Beim Sound-Labeling erhalten die Datenannotatoren eine Aufnahme und müssen alle benötigten Sounds separieren und kennzeichnen. Dabei kann es sich beispielsweise um bestimmte Schlüsselwörter oder den Klang eines bestimmten Musikinstruments handeln.

Musikklassifikation

Datenannotatoren können in dieser Art von Audioanmerkungen Genres oder Instrumente markieren. Die Musikklassifizierung ist sehr nützlich, um Musikbibliotheken zu organisieren und Benutzerempfehlungen zu verbessern.

Segmentierung auf phonetischer Ebene

Beschriftung und Klassifizierung phonetischer Segmente in den Wellenformen und Spektrogrammen von Aufnahmen von Personen, die Acapella singen.

Klangklassifizierung

Abgesehen von Stille/weißem Rauschen besteht eine Audiodatei typischerweise aus den folgenden Geräuschtypen: Sprache, Geplapper, Musik und Rauschen. Kommentieren Sie Musiknoten präzise, um eine höhere Genauigkeit zu erzielen.

Erfassung von Metadateninformationen

Erfassen Sie wichtige Informationen wie Startzeit, Endzeit, Segment-ID, Lautstärkepegel, primäre Tonart, Sprachcode, Sprecher-ID und andere Transkriptionskonventionen usw.