Large Language Models (LLM): Vollständiger Leitfaden im Jahr 2023

Alles, was Sie über LLM wissen müssen

Indextabelle

- Einleitung

- Was sind große Sprachmodelle?

- Wesentliche Faktoren

- Beliebte Beispiele für LLM

- Bausteine von LLMs

- Wie werden LLM-Modelle trainiert?

- LLM setzt auf überwachtes oder unüberwachtes Lernen

- Trainieren Sie LLM

- Der Aufstieg von LLM

- Beliebte Anwendungsfälle von LLM

- Sicherheit und Compliance

- Feinabstimmung eines LLM

- FAQ

EBook herunterladen

Einleitung

Haben Sie sich jemals am Kopf gekratzt und waren überrascht, wie Google oder Alexa Sie scheinbar „erwischt“ haben? Oder haben Sie schon einmal einen computergenerierten Aufsatz gelesen, der unheimlich menschlich klingt? Du bist nicht allein. Es ist an der Zeit, den Vorhang zu öffnen und das Geheimnis zu lüften: Large Language Models oder LLMs.

Was sind das, fragen Sie? Stellen Sie sich LLMs als versteckte Zauberer vor. Sie unterstützen unsere digitalen Chats, verstehen unsere wirren Sätze und schreiben sogar wie wir. Sie verändern unser Leben und lassen Science-Fiction Wirklichkeit werden.

In diesem Leitfaden geht es um alles, was mit LLM zu tun hat. Wir werden untersuchen, was sie können, was nicht und wo sie eingesetzt werden. Wir werden in einfacher Sprache untersuchen, wie sie sich auf uns alle auswirken.

Beginnen wir also unsere aufregende Reise in LLMs.

Für wen ist dieser Leitfaden?

Dieser umfangreiche Leitfaden ist für:

- Alle Unternehmer und Solopreneure, die regelmäßig riesige Datenmengen verarbeiten

- KI und maschinelles Lernen oder Profis, die mit Prozessoptimierungstechniken beginnen

- Projektmanager, die eine schnellere Markteinführung ihrer KI-Module oder KI-gesteuerten Produkte beabsichtigen

- Und Technikbegeisterte, die gerne in die Details der Schichten von KI-Prozessen einsteigen.

Was sind große Sprachmodelle?

Large Language Models (LLMs) sind fortschrittliche Systeme der künstlichen Intelligenz (KI), die darauf ausgelegt sind, menschenähnlichen Text zu verarbeiten, zu verstehen und zu generieren. Sie basieren auf Deep-Learning-Techniken und basieren auf riesigen Datensätzen, die normalerweise Milliarden von Wörtern aus verschiedenen Quellen wie Websites, Büchern und Artikeln enthalten. Diese umfassende Ausbildung ermöglicht es LLMs, die Nuancen von Sprache, Grammatik, Kontext und sogar einige Aspekte des Allgemeinwissens zu erfassen.

Einige beliebte LLMs, wie GPT-3 von OpenAI, verwenden eine Art neuronales Netzwerk namens Transformer, das es ihnen ermöglicht, komplexe Sprachaufgaben mit bemerkenswerter Kompetenz zu bewältigen. Diese Modelle können eine Vielzahl von Aufgaben erfüllen, wie zum Beispiel:

- Fragen beantworten

- Zusammenfassender Text

- Sprachen übersetzen

- Inhalte generieren

- Sogar interaktive Gespräche mit Benutzern führen

Während sich LLMs ständig weiterentwickeln, bergen sie ein großes Potenzial für die Verbesserung und Automatisierung verschiedener Anwendungen in allen Branchen, vom Kundenservice und der Inhaltserstellung bis hin zu Bildung und Forschung. Sie werfen jedoch auch ethische und gesellschaftliche Bedenken auf, etwa voreingenommenes Verhalten oder Missbrauch, die im Zuge des technologischen Fortschritts angegangen werden müssen.

Wesentliche Faktoren beim Aufbau eines LLM-Datenkorpus

Sie müssen einen umfassenden Datenkorpus aufbauen, um Sprachmodelle erfolgreich zu trainieren. Bei diesem Prozess geht es darum, umfangreiche Daten zu sammeln und deren hohe Qualität und Relevanz sicherzustellen. Schauen wir uns die Schlüsselaspekte an, die die Entwicklung einer effektiven Datenbibliothek für das Sprachmodelltraining maßgeblich beeinflussen.

Priorisieren Sie die Datenqualität neben der Quantität

Ein großer Datensatz ist für das Training von Sprachmodellen von grundlegender Bedeutung. Dennoch wird der Datenqualität eine große Bedeutung beigemessen. Modelle, die auf umfangreichen, aber schlecht strukturierten Daten trainiert werden, können zu ungenauen Ergebnissen führen.

Umgekehrt führen kleinere, sorgfältig kuratierte Datensätze häufig zu einer besseren Leistung. Diese Realität zeigt, wie wichtig ein ausgewogener Ansatz bei der Datenerfassung ist. Daten, die repräsentativ, vielfältig und für den beabsichtigten Umfang des Modells relevant sind, erfordern eine sorgfältige Auswahl, Bereinigung und Organisation.

Wählen Sie geeignete Datenquellen aus

Die Wahl der Datenquellen sollte sich an den spezifischen Anwendungszielen des Modells orientieren.

- Modelle, die einen Dialog erzeugen, würden von Quellen wie Gesprächen und Interviews profitieren, die von unschätzbarem Wert sind.

- Modelle, die sich auf die Codegenerierung konzentrieren, profitieren von gut dokumentierten Code-Repositorys.

- Literarische Werke und Drehbücher bieten eine Fülle von Schulungsmaterialien für diejenigen, die kreatives Schreiben anstreben.

Sie müssen Daten einschließen, die die beabsichtigten Sprachen und Themen umfassen. Es hilft Ihnen, das Modell so anzupassen, dass es innerhalb des vorgesehenen Bereichs eine effektive Leistung erbringt.

Nutzen Sie die Generierung synthetischer Daten

Die Erweiterung Ihres Datensatzes mit synthetischen Daten kann Lücken schließen und seinen Umfang erweitern. Mithilfe von Datenerweiterung, Textgenerierungsmodellen und regelbasierter Generierung können Sie künstliche Daten erstellen, die reale Muster widerspiegeln. Diese Strategie erweitert die Vielfalt des Trainingssatzes, um die Widerstandsfähigkeit des Modells zu verbessern und Vorurteile zu reduzieren.

Stellen Sie sicher, dass Sie die Qualität der synthetischen Daten überprüfen, damit sie positiv zur Fähigkeit des Modells beitragen, Sprache innerhalb seiner Zieldomäne zu verstehen und zu generieren.

Implementieren Sie eine automatisierte Datenerfassung

Die Automatisierung des Datenerfassungsprozesses erleichtert die konsistente Integration aktueller, relevanter Daten. Dieser Ansatz rationalisiert die Datenerfassung, steigert die Skalierbarkeit und fördert die Reproduzierbarkeit.

Mithilfe von Web-Scraping-Tools, APIs und Datenerfassungs-Frameworks können Sie vielfältige Datensätze effizient erfassen. Sie können diese Tools optimieren, um sich auf hochwertige, relevante Daten zu konzentrieren. Sie optimieren das Trainingsmaterial für das Modell. Sie müssen diese automatisierten Systeme kontinuierlich überwachen, um ihre Genauigkeit und ethische Integrität zu wahren.

Beliebte Beispiele für große Sprachmodelle

Hier sind einige prominente Beispiele für LLMs, die in verschiedenen Branchen weit verbreitet sind:

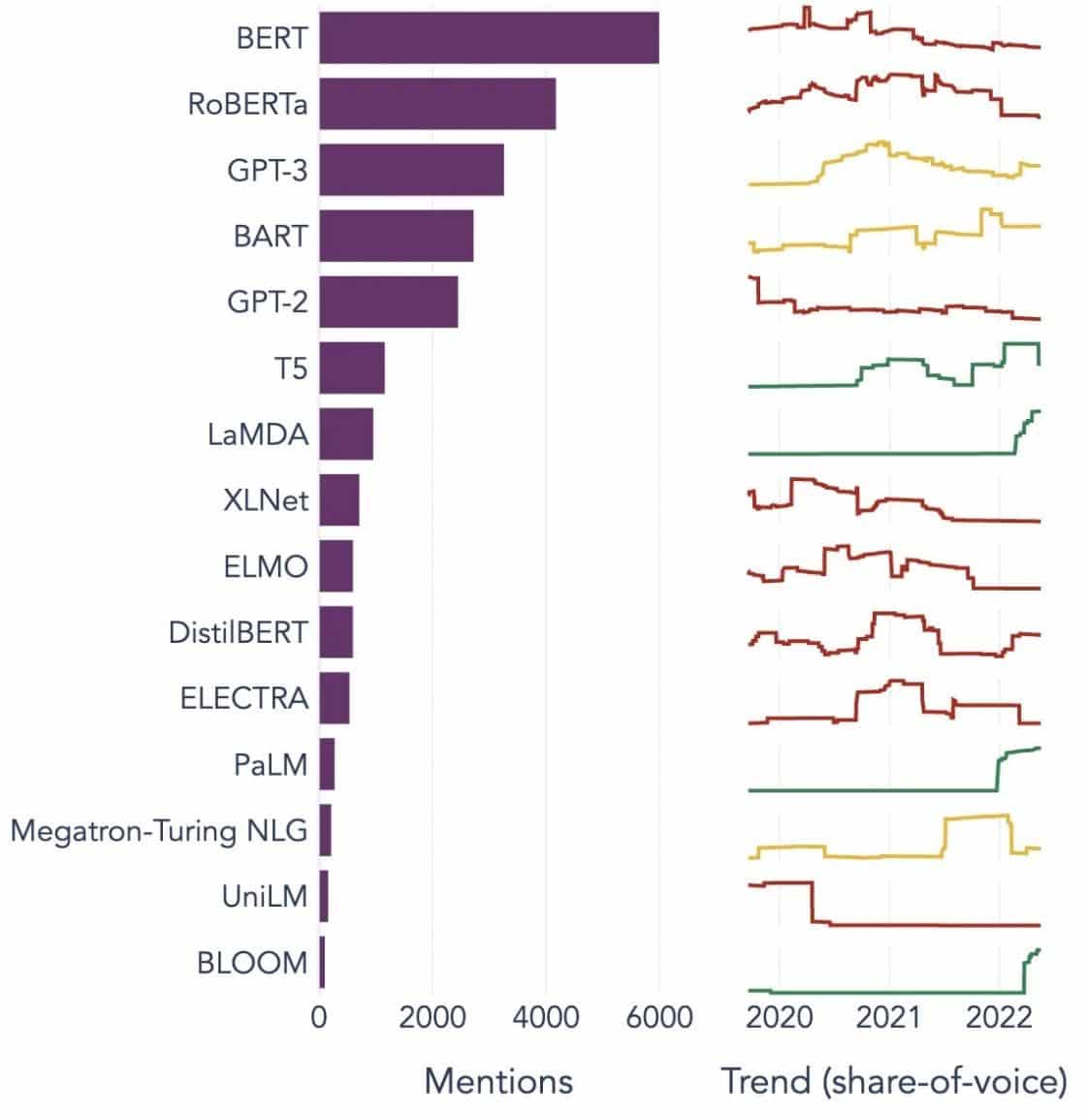

Bildquelle: Auf dem Weg zur Datenwissenschaft

Die Bausteine großer Sprachmodelle (LLMs) verstehen

Um die Fähigkeiten und Funktionsweise von LLMs vollständig zu verstehen, ist es wichtig, sich mit einigen Schlüsselkonzepten vertraut zu machen. Diese beinhalten:

Word-Einbettung

Damit ist die Praxis gemeint, Wörter in ein numerisches Format zu übersetzen, das KI-Modelle interpretieren können. Im Wesentlichen ist die Worteinbettung die Sprache der KI. Jedes Wort wird als hochdimensionaler Vektor dargestellt, der seine semantische Bedeutung basierend auf seinem Kontext in den Trainingsdaten kapselt. Diese Vektoren ermöglichen es der KI, Beziehungen und Ähnlichkeiten zwischen Wörtern zu verstehen und so das Verständnis und die Leistung des Modells zu verbessern.

Aufmerksamkeitsmechanismen

Diese hochentwickelten Komponenten helfen dem KI-Modell, beim Generieren einer Ausgabe bestimmte Elemente im Eingabetext gegenüber anderen zu priorisieren. Beispielsweise könnte ein Aufmerksamkeitsmechanismus in einem Satz, der mit verschiedenen Gefühlen gefüllt ist, den gefühlstragenden Wörtern eine höhere Gewichtung verleihen. Diese Strategie ermöglicht es der KI, kontextbezogene genauere und differenziertere Antworten zu generieren.

Transformatoren

Transformatoren stellen eine fortschrittliche Art neuronaler Netzwerkarchitektur dar, die in der LLM-Forschung häufig eingesetzt wird. Was Transformatoren auszeichnet, ist ihr Selbstaufmerksamkeitsmechanismus. Dieser Mechanismus ermöglicht es dem Modell, alle Teile der Eingabedaten gleichzeitig und nicht in sequentieller Reihenfolge zu gewichten und zu berücksichtigen. Das Ergebnis ist eine Verbesserung beim Umgang mit weitreichenden Abhängigkeiten im Text, einer häufigen Herausforderung bei der Verarbeitung natürlicher Sprache.

Feintuning

Selbst die fortschrittlichsten LLMs erfordern eine gewisse Anpassung, um in bestimmten Aufgaben oder Bereichen hervorragende Leistungen zu erbringen. Hier kommt die Feinabstimmung ins Spiel. Nachdem ein Modell zunächst auf einem großen Datensatz trainiert wurde, kann es auf einem kleineren, spezifischeren Datensatz weiter verfeinert oder „feinabgestimmt“ werden. Dieser Prozess ermöglicht es dem Modell, seine allgemeinen Sprachverständnisfähigkeiten an eine speziellere Aufgabe oder einen spezielleren Kontext anzupassen.

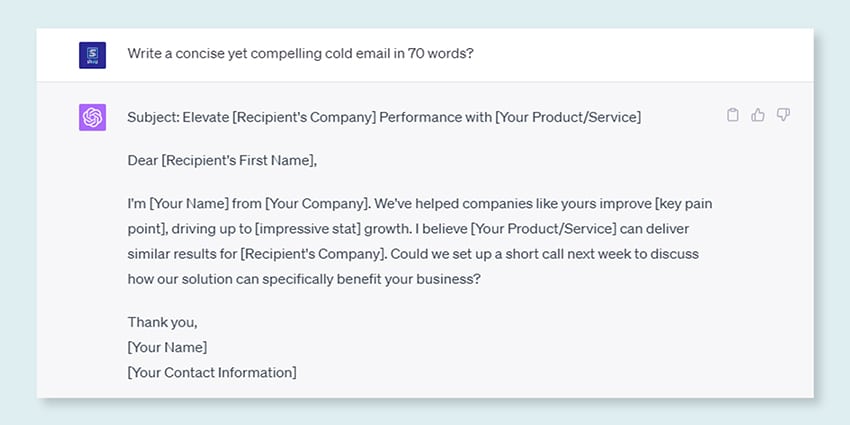

Schnelles Engineering

Eingabeaufforderungen dienen als Ausgangspunkt für LLMs, um Ausgaben zu generieren. Die effektive Gestaltung dieser Eingabeaufforderungen, eine Praxis, die als Prompt Engineering bezeichnet wird, kann einen großen Einfluss auf die Qualität der Modellantworten haben. Es handelt sich um eine Mischung aus Kunst und Wissenschaft, die ein tiefes Verständnis dafür erfordert, wie das Modell Aufforderungen interpretiert und Antworten generiert.

Befangenheit

Da LLMs aus den Daten lernen, auf denen sie trainiert werden, kann sich jede in diesen Daten vorhandene Verzerrung auf das Verhalten des Modells auswirken. Dies könnte sich in diskriminierenden oder unfairen Tendenzen in den Modellergebnissen äußern. Diese Vorurteile anzugehen und zu mildern, ist eine große Herausforderung im Bereich der KI und ein entscheidender Aspekt bei der Entwicklung ethisch einwandfreier LLMs.

Interpretierbarkeit

Angesichts der Komplexität von LLMs kann es schwierig sein zu verstehen, warum sie bestimmte Entscheidungen treffen oder bestimmte Ergebnisse generieren. Dieses als Interpretierbarkeit bekannte Merkmal ist ein Schlüsselbereich der laufenden Forschung. Die Verbesserung der Interpretierbarkeit hilft nicht nur bei der Fehlerbehebung und Modellverfeinerung, sondern stärkt auch das Vertrauen und die Transparenz in KI-Systeme.

Wie werden LLM-Modelle trainiert?

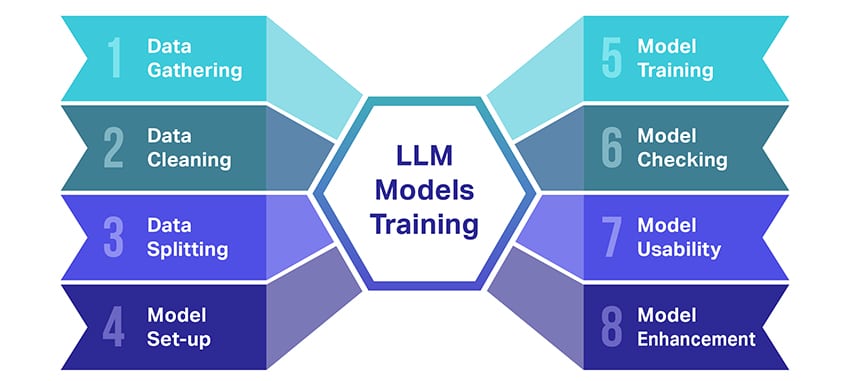

Das Training großer Sprachmodelle (LLMs) ist eine ziemliche Leistung, die mehrere entscheidende Schritte erfordert. Hier ist eine vereinfachte Schritt-für-Schritt-Übersicht des Prozesses:

- Textdaten sammeln: Das Training eines LLM beginnt mit der Erfassung einer großen Menge an Textdaten. Diese Daten können aus Büchern, Websites, Artikeln oder Social-Media-Plattformen stammen. Ziel ist es, die reiche Vielfalt der menschlichen Sprache einzufangen.

- Bereinigen der Daten: Die Rohtextdaten werden dann in einem Prozess namens Vorverarbeitung bereinigt. Dazu gehören Aufgaben wie das Entfernen unerwünschter Zeichen, das Zerlegen des Textes in kleinere Teile, sogenannte Token, und das Überführen des Ganzen in ein Format, mit dem das Modell arbeiten kann.

- Aufteilen der Daten: Als nächstes werden die sauberen Daten in zwei Sätze aufgeteilt. Ein Satz, die Trainingsdaten, wird zum Trainieren des Modells verwendet. Der andere Satz, die Validierungsdaten, wird später zum Testen der Leistung des Modells verwendet.

- Einrichten des Modells: Anschließend wird die Struktur des LLM, die sogenannte Architektur, definiert. Dazu gehört die Auswahl des Typs des neuronalen Netzwerks und die Festlegung verschiedener Parameter, beispielsweise der Anzahl der Schichten und versteckten Einheiten innerhalb des Netzwerks.

- Trainieren des Modells: Nun beginnt das eigentliche Training. Das LLM-Modell lernt, indem es sich die Trainingsdaten ansieht, auf der Grundlage dessen, was es bisher gelernt hat, Vorhersagen trifft und dann seine internen Parameter anpasst, um den Unterschied zwischen seinen Vorhersagen und den tatsächlichen Daten zu verringern.

- Überprüfung des Modells: Das Lernen des LLM-Modells wird anhand der Validierungsdaten überprüft. Auf diese Weise können Sie sehen, wie gut das Modell funktioniert, und die Einstellungen des Modells optimieren, um eine bessere Leistung zu erzielen.

- Verwendung des Modells: Nach dem Training und der Evaluierung ist das LLM-Modell einsatzbereit. Es kann jetzt in Anwendungen oder Systeme integriert werden, wo es Text basierend auf neuen Eingaben generiert.

- Verbesserung des Modells: Schließlich gibt es immer Raum für Verbesserungen. Das LLM-Modell kann im Laufe der Zeit weiter verfeinert werden, indem aktualisierte Daten verwendet oder Einstellungen basierend auf Feedback und realer Nutzung angepasst werden.

Bedenken Sie, dass dieser Prozess erhebliche Rechenressourcen wie leistungsstarke Verarbeitungseinheiten und großen Speicher sowie Spezialkenntnisse im maschinellen Lernen erfordert. Aus diesem Grund wird dies in der Regel von engagierten Forschungsorganisationen oder Unternehmen durchgeführt, die über die erforderliche Infrastruktur und das erforderliche Fachwissen verfügen.

Verlässt sich das LLM auf überwachtes oder unüberwachtes Lernen?

Große Sprachmodelle werden normalerweise mit einer Methode trainiert, die als überwachtes Lernen bezeichnet wird. Vereinfacht ausgedrückt bedeutet dies, dass sie anhand von Beispielen lernen, die ihnen die richtigen Antworten zeigen.

Wenn Sie also ein LLM mit einem Satz füttern, versucht es, das nächste Wort oder die nächste Phrase basierend auf dem, was es aus den Beispielen gelernt hat, vorherzusagen. Auf diese Weise lernt es, Texte zu generieren, die Sinn ergeben und zum Kontext passen.

Allerdings nutzen LLMs manchmal auch ein wenig unbeaufsichtigtes Lernen. Das ist so, als würde man das Kind einen Raum voller verschiedener Spielsachen erkunden und selbst etwas über sie lernen. Das Modell betrachtet unbeschriftete Daten, Lernmuster und Strukturen, ohne dass ihm die „richtigen“ Antworten gesagt werden.

Beim überwachten Lernen werden Daten verwendet, die mit Eingaben und Ausgaben gekennzeichnet sind, im Gegensatz zum unüberwachten Lernen, bei dem keine gekennzeichneten Ausgabedaten verwendet werden.

Kurz gesagt: LLMs werden hauptsächlich durch überwachtes Lernen trainiert, sie können jedoch auch unüberwachtes Lernen nutzen, um ihre Fähigkeiten zu verbessern, beispielsweise für explorative Analysen und Dimensionsreduktion.

Welches Datenvolumen (in GB) ist zum Trainieren eines großen Sprachmodells erforderlich?

Die Welt der Möglichkeiten für Sprachdatenerkennung und Sprachanwendungen ist immens und sie werden in mehreren Branchen für eine Vielzahl von Anwendungen eingesetzt.

Das Training eines großen Sprachmodells ist kein einheitlicher Prozess, insbesondere wenn es um die benötigten Daten geht. Es hängt von einer Reihe von Dingen ab:

- Der Modellentwurf.

- Welche Aufgabe muss es erfüllen?

- Die Art der Daten, die Sie verwenden.

- Wie gut soll es funktionieren?

Allerdings erfordert das Training von LLMs normalerweise eine riesige Menge an Textdaten. Aber von wie massiv reden wir? Denken Sie weit über Gigabyte (GB) hinaus. In der Regel handelt es sich um Terabytes (TB) oder sogar Petabytes (PB) an Daten.

Betrachten Sie GPT-3, eines der größten LLMs überhaupt. Darauf wird trainiert 570 GB Textdaten. Kleinere LLMs benötigen möglicherweise weniger – vielleicht 10–20 GB oder sogar 1 GB Gigabyte –, aber es ist immer noch viel.

Aber es kommt nicht nur auf die Größe der Daten an. Qualität ist auch wichtig. Die Daten müssen sauber und abwechslungsreich sein, damit das Modell effektiv lernen kann. Und Sie dürfen andere wichtige Puzzleteile nicht vergessen, wie die benötigte Rechenleistung, die Algorithmen, die Sie für das Training verwenden, und die Hardware-Ausstattung, die Sie haben. All diese Faktoren spielen bei der Ausbildung eines LLM eine große Rolle.

Der Aufstieg großer Sprachmodelle: Warum sie wichtig sind

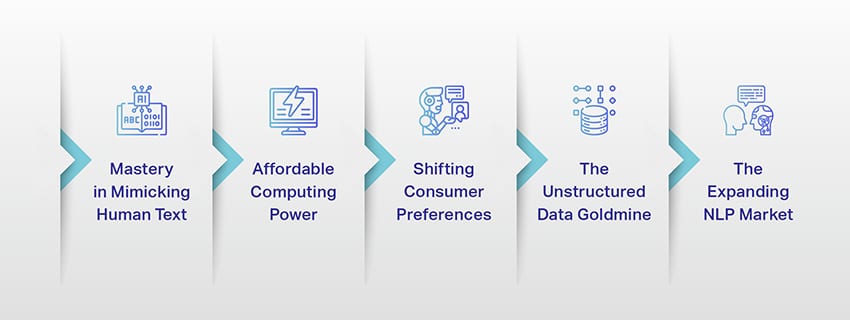

LLMs sind nicht mehr nur ein Konzept oder ein Experiment. Sie spielen in unserer digitalen Landschaft zunehmend eine entscheidende Rolle. Aber warum passiert das? Was macht diese LLMs so wichtig? Lassen Sie uns auf einige Schlüsselfaktoren eingehen.

Beherrschung der Nachahmung menschlichen Textes

LLMs haben die Art und Weise, wie wir sprachbasierte Aufgaben bearbeiten, verändert. Diese Modelle basieren auf robusten Algorithmen für maschinelles Lernen und sind mit der Fähigkeit ausgestattet, die Nuancen der menschlichen Sprache zu verstehen, einschließlich Kontext, Emotionen und in gewissem Maße sogar Sarkasmus. Diese Fähigkeit, die menschliche Sprache nachzuahmen, ist keine bloße Neuheit, sie hat erhebliche Auswirkungen.

Die fortschrittlichen Textgenerierungsfähigkeiten von LLMs können alles von der Inhaltserstellung bis zur Interaktion mit dem Kundenservice verbessern.

Stellen Sie sich vor, Sie könnten einem digitalen Assistenten eine komplexe Frage stellen und eine Antwort erhalten, die nicht nur Sinn ergibt, sondern auch schlüssig und relevant ist und in einem verständlichen Ton vermittelt wird. Das ist es, was LLMs ermöglichen. Sie fördern eine intuitivere und ansprechendere Mensch-Maschine-Interaktion, bereichern das Benutzererlebnis und demokratisieren den Zugang zu Informationen.

Erschwingliche Rechenleistung

Der Aufstieg der LLMs wäre ohne parallele Entwicklungen im Bereich der Informatik nicht möglich gewesen. Genauer gesagt hat die Demokratisierung der Rechenressourcen eine bedeutende Rolle bei der Entwicklung und Einführung von LLMs gespielt.

Cloudbasierte Plattformen bieten einen beispiellosen Zugang zu Hochleistungs-Computing-Ressourcen. Auf diese Weise können auch kleine Organisationen und unabhängige Forscher anspruchsvolle Modelle für maschinelles Lernen trainieren.

Darüber hinaus haben Verbesserungen bei Verarbeitungseinheiten (wie GPUs und TPUs) in Verbindung mit dem Aufkommen verteilter Datenverarbeitung das Trainieren von Modellen mit Milliarden von Parametern möglich gemacht. Diese verbesserte Zugänglichkeit von Rechenleistung ermöglicht das Wachstum und den Erfolg von LLMs und führt zu mehr Innovationen und Anwendungen in diesem Bereich.

Veränderte Verbraucherpräferenzen

Verbraucher wollen heute nicht nur Antworten; Sie wollen ansprechende und nachvollziehbare Interaktionen. Da immer mehr Menschen mit digitaler Technologie aufwachsen, ist es offensichtlich, dass der Bedarf an Technologie, die sich natürlicher und menschlicher anfühlt, zunimmt. LLMs bieten eine beispiellose Gelegenheit, diese Erwartungen zu erfüllen. Durch die Generierung menschenähnlicher Texte können diese Modelle ansprechende und dynamische digitale Erlebnisse schaffen, die die Zufriedenheit und Loyalität der Benutzer erhöhen können. Ob KI-Chatbots für den Kundenservice oder Sprachassistenten für Nachrichtenaktualisierungen: LLMs läuten eine Ära der KI ein, die uns besser versteht.

Die Goldgrube für unstrukturierte Daten

Unstrukturierte Daten wie E-Mails, Social-Media-Beiträge und Kundenrezensionen sind eine Fundgrube an Erkenntnissen. Es wird geschätzt, dass das vorbei ist 80% der Unternehmensdaten sind unstrukturiert und wachsen mit einer Rate von 55% pro Jahr. Diese Daten sind eine Goldgrube für Unternehmen, wenn sie richtig genutzt werden.

Hier kommen LLMs mit ihrer Fähigkeit ins Spiel, solche Daten in großem Maßstab zu verarbeiten und zu verstehen. Sie können Aufgaben wie Sentimentanalyse, Textklassifizierung, Informationsextraktion und mehr übernehmen und so wertvolle Erkenntnisse liefern.

Ganz gleich, ob es darum geht, Trends aus Social-Media-Beiträgen zu erkennen oder die Kundenstimmung anhand von Bewertungen zu messen: LLMs helfen Unternehmen dabei, sich in der großen Menge unstrukturierter Daten zurechtzufinden und datengesteuerte Entscheidungen zu treffen.

Der expandierende NLP-Markt

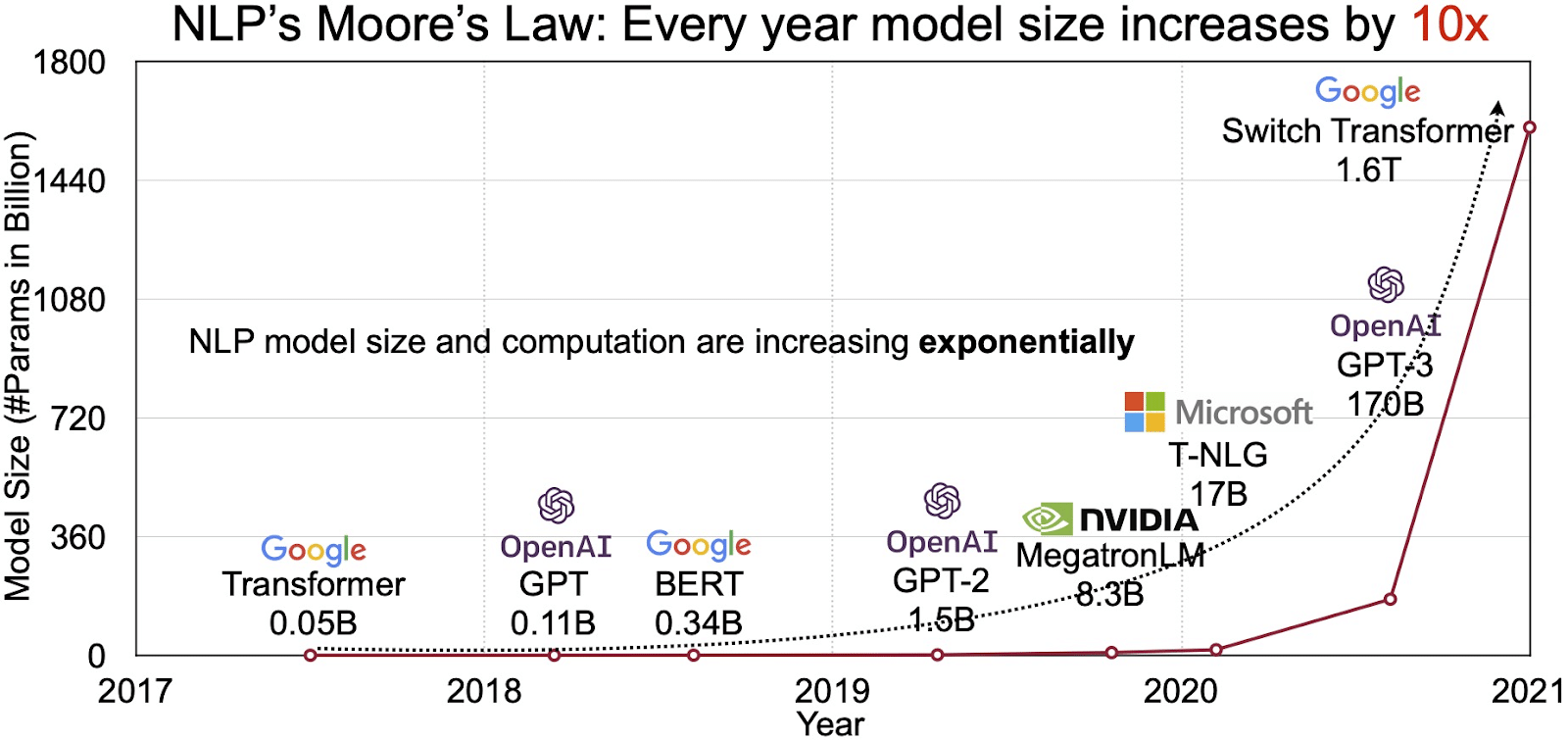

Das Potenzial von LLMs spiegelt sich im schnell wachsenden Markt für natürliche Sprachverarbeitung (NLP) wider. Analysten gehen davon aus, dass der NLP-Markt weiter wachsen wird 11 Milliarden US-Dollar im Jahr 2020 auf über 35 Milliarden US-Dollar im Jahr 2026. Aber nicht nur die Marktgröße wächst. Auch die Modelle selbst wachsen, sowohl in der physischen Größe als auch in der Anzahl der von ihnen verarbeiteten Parameter. Die Entwicklung von LLMs im Laufe der Jahre, wie in der Abbildung unten (Bildquelle: Link) zu sehen ist, unterstreicht ihre zunehmende Komplexität und Kapazität.

Beliebte Anwendungsfälle großer Sprachmodelle

Hier sind einige der wichtigsten und am weitesten verbreiteten Anwendungsfälle von LLM:

- Erzeugen von Text in natürlicher Sprache: Large Language Models (LLMs) kombinieren die Leistungsfähigkeit künstlicher Intelligenz und Computerlinguistik, um autonom Texte in natürlicher Sprache zu produzieren. Sie können auf unterschiedliche Benutzerbedürfnisse eingehen, z. B. das Verfassen von Artikeln, das Erstellen von Liedern oder die Teilnahme an Gesprächen mit Benutzern.

- Übersetzung durch Maschinen: LLMs können effektiv zum Übersetzen von Text zwischen beliebigen Sprachpaaren eingesetzt werden. Diese Modelle nutzen Deep-Learning-Algorithmen wie wiederkehrende neuronale Netze, um die sprachliche Struktur sowohl der Ausgangs- als auch der Zielsprache zu verstehen und so die Übersetzung des Ausgangstextes in die gewünschte Sprache zu erleichtern.

- Erstellen von Originalinhalten: LLMs haben Maschinen die Möglichkeit eröffnet, zusammenhängende und logische Inhalte zu generieren. Dieser Inhalt kann zum Erstellen von Blogbeiträgen, Artikeln und anderen Arten von Inhalten verwendet werden. Die Modelle nutzen ihre fundierte Deep-Learning-Erfahrung, um die Inhalte auf neuartige und benutzerfreundliche Weise zu formatieren und zu strukturieren.

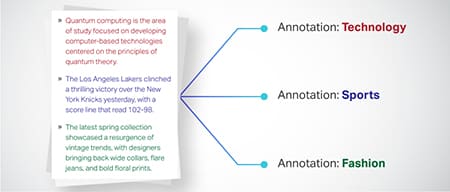

- Stimmungen analysieren: Eine interessante Anwendung großer Sprachmodelle ist die Stimmungsanalyse. Dabei wird das Modell darauf trainiert, im annotierten Text vorhandene emotionale Zustände und Gefühle zu erkennen und zu kategorisieren. Die Software kann Emotionen wie Positivität, Negativität, Neutralität und andere komplexe Gefühle identifizieren. Dies kann wertvolle Erkenntnisse über Kundenfeedback und Ansichten zu verschiedenen Produkten und Dienstleistungen liefern.

- Text verstehen, zusammenfassen und klassifizieren: LLMs schaffen eine tragfähige Struktur für KI-Software zur Interpretation des Textes und seines Kontexts. Indem sie das Modell anweisen, riesige Datenmengen zu verstehen und zu untersuchen, ermöglichen LLMs KI-Modellen, Texte in verschiedenen Formen und Mustern zu verstehen, zusammenzufassen und sogar zu kategorisieren.

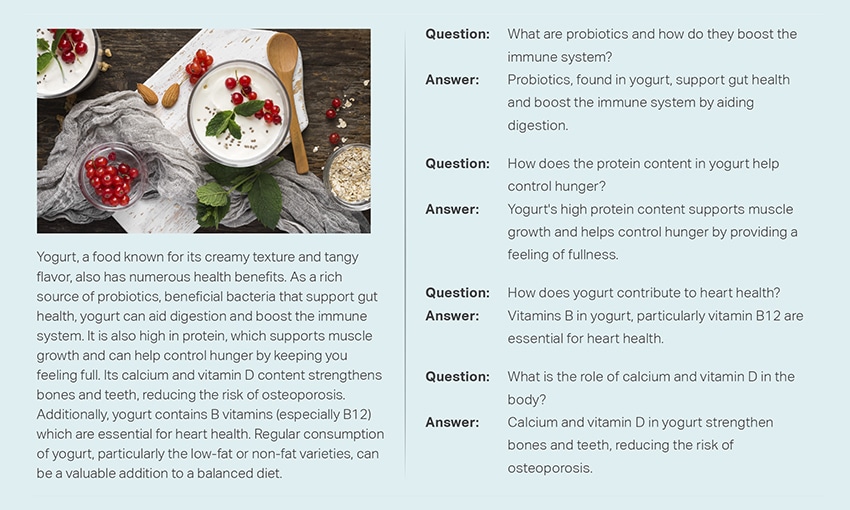

- Fragen beantworten: Große Sprachmodelle statten Frage-Antwort-Systeme (QA) mit der Fähigkeit aus, die Anfrage eines Benutzers in natürlicher Sprache genau wahrzunehmen und darauf zu reagieren. Beliebte Beispiele für diesen Anwendungsfall sind ChatGPT und BERT, die den Kontext einer Anfrage untersuchen und eine riesige Sammlung von Texten durchsuchen, um relevante Antworten auf Benutzerfragen zu liefern.

Integration von Sicherheit und Compliance in LLM-Datenstrategien

Die Einbettung robuster Sicherheits- und Compliance-Maßnahmen in LLM-Datenerfassungs- und -verarbeitungsrahmen kann Ihnen dabei helfen, eine transparente, sichere und ethische Nutzung der Daten sicherzustellen. Dieser Ansatz umfasst mehrere Schlüsselmaßnahmen:

- Implementieren Sie eine robuste Verschlüsselung: Schützen Sie ruhende und übertragene Daten mithilfe starker Verschlüsselungsmethoden. Dieser Schritt schützt Informationen vor unbefugtem Zugriff und Verstößen.

- Richten Sie Zugriffskontrollen und Authentifizierung ein: Richten Sie Systeme ein, um Benutzeridentitäten zu überprüfen und den Zugriff auf Daten einzuschränken. Dadurch wird sichergestellt, dass nur autorisiertes Personal mit vertraulichen Informationen interagieren kann.

- Integrieren Sie Protokollierungs- und Überwachungssysteme: Stellen Sie Systeme bereit, um die Datennutzung zu verfolgen und potenzielle Sicherheitsbedrohungen zu identifizieren. Diese proaktive Überwachung trägt dazu bei, die Integrität und Sicherheit des Datenökosystems aufrechtzuerhalten.

- Halten Sie sich an Compliance-Standards: Befolgen Sie relevante Vorschriften wie DSGVO, HIPAA und PCI DSS, die Datensicherheit und Datenschutz regeln. Regelmäßige Audits und Kontrollen überprüfen die Einhaltung und stellen sicher, dass die Praktiken branchenspezifischen rechtlichen und ethischen Standards entsprechen.

- Legen Sie Richtlinien zur ethischen Datennutzung fest: Richtlinien entwickeln und durchsetzen, die eine faire, transparente und verantwortungsvolle Nutzung von Daten vorschreiben. Diese Richtlinien tragen dazu bei, das Vertrauen der Stakeholder aufrechtzuerhalten und eine sichere Schulungsumgebung für LLMs zu unterstützen.

Diese Maßnahmen stärken gemeinsam die Datenverwaltungspraktiken für die LLM-Ausbildung. Es schafft eine Grundlage für Vertrauen und Sicherheit, die allen Beteiligten zugutekommt.

Feinabstimmung eines großen Sprachmodells

Die Feinabstimmung eines großen Sprachmodells erfordert einen sorgfältigen Annotationsprozess. Shaip kann mit seiner Expertise auf diesem Gebiet dieses Unterfangen erheblich unterstützen. Hier sind einige Annotationsmethoden, die zum Trainieren von Modellen wie ChatGPT verwendet werden:

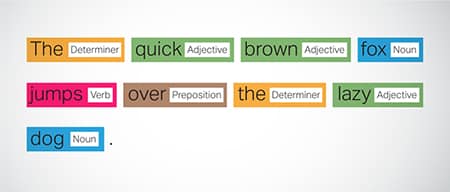

Part-of-Speech (POS)-Tagging

Wörter in Sätzen werden mit ihrer grammatikalischen Funktion markiert, beispielsweise Verben, Substantive, Adjektive usw. Dieser Prozess hilft dem Modell, die Grammatik und die Verknüpfungen zwischen Wörtern zu verstehen.

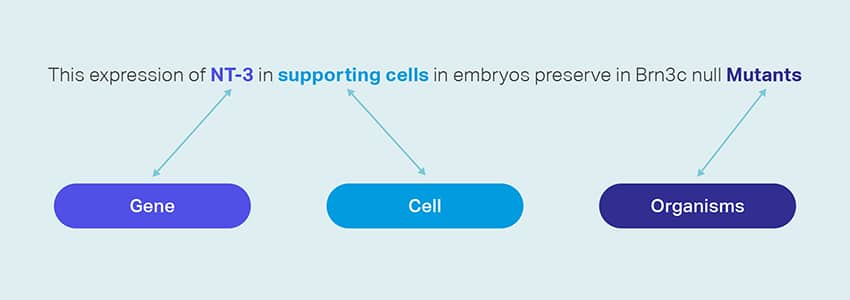

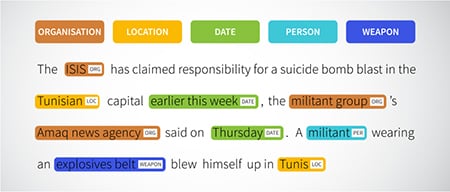

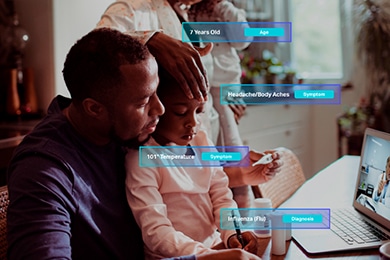

Anerkennung benannter Entitäten (NER)

Benannte Entitäten wie Organisationen, Standorte und Personen innerhalb eines Satzes werden markiert. Diese Übung unterstützt das Modell bei der Interpretation der semantischen Bedeutung von Wörtern und Phrasen und liefert präzisere Antworten.

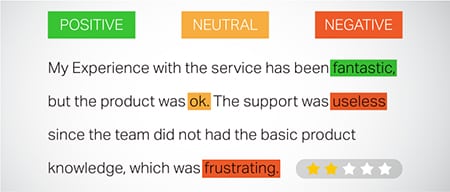

Stimmungsanalyse

Den Textdaten werden Stimmungsbezeichnungen wie „positiv“, „neutral“ oder „negativ“ zugewiesen, die dem Modell helfen, den emotionalen Unterton von Sätzen zu erfassen. Es ist besonders nützlich bei der Beantwortung von Fragen, die Emotionen und Meinungen betreffen.

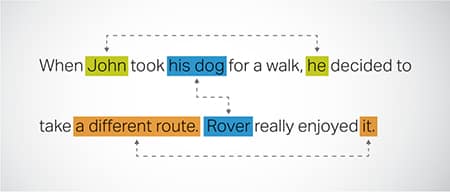

Koreferenzauflösung

Identifizieren und Beheben von Fällen, in denen in verschiedenen Teilen eines Textes auf dieselbe Entität verwiesen wird. Dieser Schritt hilft dem Modell, den Kontext des Satzes zu verstehen, und führt so zu kohärenten Antworten.

Textklassifizierung

Textdaten werden in vordefinierte Gruppen wie Produktbewertungen oder Nachrichtenartikel kategorisiert. Dies hilft dem Modell, das Genre oder Thema des Textes zu erkennen und relevantere Antworten zu generieren.

Saip kann Trainingsdaten durch Web-Crawling aus verschiedenen Sektoren wie Banken, Versicherungen, Einzelhandel und Telekommunikation sammeln. Wir können Textanmerkungen bereitstellen (NER, Stimmungsanalyse usw.), mehrsprachiges LLM (Übersetzung) erleichtern und bei der Taxonomieerstellung, Extraktion/Prompt-Engineering helfen.

Shaip verfügt über ein umfangreiches Repository mit handelsüblichen Datensätzen. Unser medizinischer Datenkatalog verfügt über eine breite Sammlung anonymisierter, sicherer und qualitativ hochwertiger Daten, die für KI-Initiativen, Modelle für maschinelles Lernen und die Verarbeitung natürlicher Sprache geeignet sind.

Ebenso ist unser Sprachdatenkatalog eine Fundgrube an hochwertigen Daten, die sich perfekt für Spracherkennungsprodukte eignen und ein effizientes Training von KI/ML-Modellen ermöglichen. Darüber hinaus verfügen wir über einen beeindruckenden Computer-Vision-Datenkatalog mit einer breiten Palette an Bild- und Videodaten für verschiedene Anwendungen.

Wir bieten sogar offene Datensätze in einer modifizierbaren und praktischen Form kostenlos zur Verwendung in Ihren KI- und ML-Projekten an. Mit dieser umfangreichen KI-Datenbibliothek können Sie Ihre KI- und ML-Modelle effizienter und genauer entwickeln.

Shaips Datenerfassungs- und Annotationsprozess

Wenn es um Datenerfassung und Annotation geht, Saip folgt einem optimierten Arbeitsablauf. So sieht der Datenerfassungsprozess aus:

Identifizierung von Quellwebsites

Zunächst werden Websites anhand ausgewählter Quellen und Schlüsselwörter identifiziert, die für die benötigten Daten relevant sind.

Web Scraping

Sobald die relevanten Websites identifiziert sind, nutzt Shaip sein proprietäres Tool, um Daten von diesen Websites zu extrahieren.

Textvorverarbeitung

Die gesammelten Daten werden einer ersten Verarbeitung unterzogen, die eine Satzaufteilung und -analyse umfasst, sodass sie für weitere Schritte geeignet sind.

Anmerkung

Die vorverarbeiteten Daten werden für die Extraktion benannter Entitäten mit Anmerkungen versehen. Bei diesem Prozess geht es darum, wichtige Elemente im Text zu identifizieren und zu kennzeichnen, wie z. B. Namen von Personen, Organisationen, Orten usw.

Beziehungsextraktion

Im letzten Schritt werden die Beziehungstypen zwischen den identifizierten Entitäten bestimmt und entsprechend annotiert. Dies hilft beim Verständnis der semantischen Zusammenhänge zwischen verschiedenen Textbestandteilen.

Shaips Opfergabe

Saip bietet eine breite Palette von Dienstleistungen an, die Unternehmen bei der Verwaltung, Analyse und optimalen Nutzung ihrer Daten unterstützen.

Daten-Web-Scraping

Ein wichtiger Service von Shaip ist das Data Scraping. Dabei handelt es sich um die Extraktion von Daten aus domänenspezifischen URLs. Durch den Einsatz automatisierter Tools und Techniken kann Shaip schnell und effizient große Datenmengen von verschiedenen Websites, Produkthandbüchern, technischen Dokumentationen, Online-Foren, Online-Bewertungen, Kundendienstdaten, Branchenregulierungsdokumenten usw. entfernen. Dieser Prozess kann für Unternehmen von unschätzbarem Wert sein, wenn Sammeln relevanter und spezifischer Daten aus einer Vielzahl von Quellen.

Maschinelle Übersetzung

Entwickeln Sie Modelle mithilfe umfangreicher mehrsprachiger Datensätze gepaart mit entsprechenden Transkriptionen für die Übersetzung von Texten in verschiedene Sprachen. Dieser Prozess trägt zum Abbau sprachlicher Hürden bei und fördert die Zugänglichkeit von Informationen.

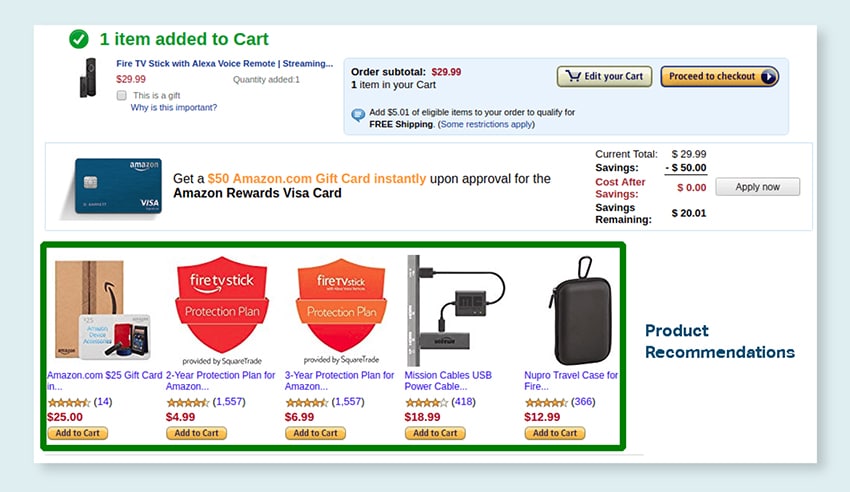

Taxonomie-Extraktion und -Erstellung

Shaip kann bei der Extraktion und Erstellung von Taxonomien helfen. Dabei werden Daten in einem strukturierten Format klassifiziert und kategorisiert, das die Beziehungen zwischen verschiedenen Datenpunkten widerspiegelt. Dies kann besonders für Unternehmen nützlich sein, um ihre Daten zu organisieren und sie leichter zugänglich und einfacher zu analysieren. In einem E-Commerce-Unternehmen können Produktdaten beispielsweise nach Produkttyp, Marke, Preis usw. kategorisiert werden, um Kunden die Navigation im Produktkatalog zu erleichtern.

Datensammlung

Unsere Datenerfassungsdienste liefern wichtige reale oder synthetische Daten, die für das Training generativer KI-Algorithmen und die Verbesserung der Genauigkeit und Effektivität Ihrer Modelle erforderlich sind. Die Daten stammen aus unvoreingenommenen, ethisch vertretbaren und verantwortungsvollen Quellen unter Berücksichtigung von Datenschutz und Sicherheit.

Fragen und Antworten

Die Beantwortung von Fragen (QA) ist ein Teilbereich der Verarbeitung natürlicher Sprache, der sich auf die automatische Beantwortung von Fragen in menschlicher Sprache konzentriert. QA-Systeme werden anhand umfangreicher Texte und Codes geschult, sodass sie verschiedene Arten von Fragen bearbeiten können, darunter sachliche, definitorische und meinungsbasierte Fragen. Domänenkenntnisse sind für die Entwicklung von QA-Modellen, die auf bestimmte Bereiche wie Kundensupport, Gesundheitswesen oder Lieferkette zugeschnitten sind, von entscheidender Bedeutung. Generative QA-Ansätze ermöglichen es Modellen jedoch, Texte ohne Domänenkenntnisse zu generieren und sich ausschließlich auf den Kontext zu verlassen.

Unser Spezialistenteam kann umfassende Dokumente oder Handbücher sorgfältig studieren, um Frage-Antwort-Paare zu generieren und so die Entwicklung generativer KI für Unternehmen zu erleichtern. Dieser Ansatz kann Benutzeranfragen effektiv beantworten, indem er relevante Informationen aus einem umfangreichen Korpus extrahiert. Unsere zertifizierten Experten stellen die Erstellung hochwertiger Frage-und-Antwort-Paare sicher, die sich über verschiedene Themen und Bereiche erstrecken.

Textzusammenfassung

Unsere Spezialisten sind in der Lage, umfassende Gespräche oder lange Dialoge zu destillieren und aus umfangreichen Textdaten prägnante und aufschlussreiche Zusammenfassungen zu liefern.

Textgenerierung

Trainieren Sie Modelle mithilfe eines breiten Textdatensatzes in verschiedenen Stilrichtungen, z. B. Nachrichtenartikeln, Belletristik und Gedichten. Diese Modelle können dann verschiedene Arten von Inhalten generieren, darunter Nachrichtenbeiträge, Blogeinträge oder Social-Media-Beiträge, und bieten so eine kostengünstige und zeitsparende Lösung für die Inhaltserstellung.

Spracherkennung

Entwickeln Sie Modelle, die gesprochene Sprache für verschiedene Anwendungen verstehen können. Dazu gehören sprachaktivierte Assistenten, Diktiersoftware und Echtzeit-Übersetzungstools. Der Prozess umfasst die Verwendung eines umfassenden Datensatzes, der aus Audioaufzeichnungen gesprochener Sprache besteht, gepaart mit den entsprechenden Transkripten.

Produktempfehlungen

Entwickeln Sie Modelle anhand umfangreicher Datensätze zur Kaufhistorie von Kunden, einschließlich Etiketten, die darauf hinweisen, welche Produkte Kunden kaufen möchten. Ziel ist es, den Kunden präzise Vorschläge zu machen und so den Umsatz anzukurbeln und die Kundenzufriedenheit zu steigern.

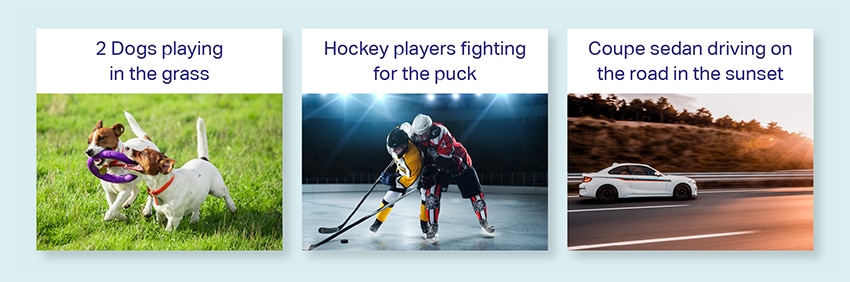

Bilduntertitelung

Revolutionieren Sie Ihren Bildinterpretationsprozess mit unserem hochmodernen, KI-gesteuerten Bildunterschriftenservice. Wir verleihen Bildern Lebendigkeit, indem wir genaue und kontextbedeutende Beschreibungen erstellen. Dies ebnet den Weg für innovative Engagement- und Interaktionsmöglichkeiten mit Ihren visuellen Inhalten für Ihr Publikum.

Schulung von Text-to-Speech-Diensten

Wir stellen einen umfangreichen Datensatz aus Audioaufzeichnungen menschlicher Sprache bereit, der sich ideal für das Training von KI-Modellen eignet. Diese Modelle sind in der Lage, natürliche und ansprechende Stimmen für Ihre Anwendungen zu erzeugen und so Ihren Benutzern ein unverwechselbares und immersives Klangerlebnis zu bieten.

Unser vielfältiger Datenkatalog ist darauf ausgelegt, zahlreiche Anwendungsfälle der generativen KI abzudecken

Standardmäßiger medizinischer Datenkatalog und Lizenzierung:

- 5 Millionen Aufzeichnungen und Audiodateien von Ärzten in 31 Fachgebieten

- 2M+ Medizinische Bilder in der Radiologie und anderen Fachgebieten (MRTs, CTs, USGs, XRs)

- Über 30 klinische Textdokumente mit wertschöpfenden Entitäten und Beziehungsanmerkungen

Standardmäßiger Sprachdatenkatalog und Lizenzierung:

- Über 40 Stunden Sprachdaten (50+ Sprachen/100+ Dialekte)

- Über 55 behandelte Themen

- Abtastrate – 8/16/44/48 kHz

- Audiotyp: Spontane, vorgefertigte, monologe Worte, Weckworte

- Vollständig transkribierte Audiodatensätze in mehreren Sprachen für Mensch-Mensch-Gespräche, Mensch-Bot-Gespräche, Mensch-Agent-Callcenter-Gespräche, Monologe, Reden, Podcasts usw.

Bild- und Videodatenkatalog & Lizenzierung:

- Bildsammlung von Lebensmitteln/Dokumenten

- Videosammlung zur Haussicherheit

- Sammlung von Gesichtsbildern/-videos

- Rechnungen, Bestellungen, Belegsammlung für OCR

- Bilderfassung für die Fahrzeugschadenserkennung

- Bildsammlung für Kfz-Kennzeichen

- Sammlung von Autoinnenbildern

- Bildersammlung mit Autofahrer im Fokus

- Modebezogene Bildersammlung

diskutieren

Häufig gestellte Fragen (FAQ)

DL ist ein Teilgebiet von ML, das künstliche neuronale Netze mit mehreren Schichten nutzt, um komplexe Muster in Daten zu lernen. ML ist eine Teilmenge der KI, die sich auf Algorithmen und Modelle konzentriert, die es Maschinen ermöglichen, aus Daten zu lernen. Große Sprachmodelle (LLMs) sind eine Teilmenge des Deep Learning und haben Gemeinsamkeiten mit der generativen KI, da beide Bestandteile des breiteren Bereichs des Deep Learning sind.

Große Sprachmodelle (LLMs) sind umfangreiche und vielseitige Sprachmodelle, die zunächst anhand umfangreicher Textdaten vorab trainiert werden, um die grundlegenden Aspekte der Sprache zu erfassen. Anschließend werden sie auf bestimmte Anwendungen oder Aufgaben abgestimmt und können so für bestimmte Zwecke angepasst und optimiert werden.

Erstens verfügen große Sprachmodelle aufgrund ihres umfangreichen Trainings mit riesigen Datenmengen und Milliarden von Parametern über die Fähigkeit, ein breites Spektrum an Aufgaben zu bewältigen.

Zweitens sind diese Modelle anpassungsfähig, da sie mit minimalen spezifischen Feldtrainingsdaten feinabgestimmt werden können.

Schließlich verbessert sich die Leistung von LLMs kontinuierlich, wenn zusätzliche Daten und Parameter einbezogen werden, wodurch ihre Wirksamkeit im Laufe der Zeit gesteigert wird.

Bei der Gestaltung von Eingabeaufforderungen handelt es sich um die Erstellung einer Eingabeaufforderung, die auf die spezifische Aufgabe zugeschnitten ist, beispielsweise die Angabe der gewünschten Ausgabesprache in einer Übersetzungsaufgabe. Prompt Engineering hingegen konzentriert sich auf die Optimierung der Leistung durch die Einbeziehung von Domänenwissen, die Bereitstellung von Ausgabebeispielen oder die Verwendung effektiver Schlüsselwörter. Prompt Design ist ein allgemeines Konzept, während Prompt Engineering ein spezialisierter Ansatz ist. Während ein zeitnaher Entwurf für alle Systeme unerlässlich ist, wird eine zeitnahe Konstruktion für Systeme, die eine hohe Genauigkeit oder Leistung erfordern, von entscheidender Bedeutung.

Es gibt drei Arten großer Sprachmodelle. Jeder Typ erfordert einen anderen Ansatz zur Förderung.

- Generische Sprachmodelle sagen das nächste Wort basierend auf der Sprache in den Trainingsdaten voraus.

- Anweisungsabgestimmte Modelle werden trainiert, um die Reaktion auf die in der Eingabe gegebenen Anweisungen vorherzusagen.

- Auf Dialog abgestimmte Modelle werden darauf trainiert, eine dialogähnliche Konversation zu führen, indem sie die nächste Antwort generieren.